Inhaltsverzeichnis

Depuis ses origines magiques et divines, la loi n’a cessé de chercher ses fondements dans une raison en constante évolution. De la figure divine du grand horloger chère à Voltaire en passant par celle du juriste comme ingénieur de la société au XXe siècle, le législateur s’ancre désormais résolument dans l’ère digitale, celle de la cybernétique, de l’intelligence artificielle, des algorithmes et des robots où l’automatisation devient le maître-mot (Flückiger 2019, 56 ss).

La digitalisation ne modifie pas seulement la genèse et la diffusion de la loi (nouvelles formes de participation, édition facilitée des textes ou diffusion élargie de ceux-ci [Gasser/Drolshammer 2015, 87 ss]), mais affecte son application même, appelée à s’automatiser grâce aux progrès fulgurants de l’intelligence artificielle. Ces derniers développements ont en effet fait renaître un vieux rêve toujours vivace chez une partie des juristes : celui de l’application automatique des lois, assurant la sécurité du droit, la prévisibilité du jugement tout en limitant le pouvoir créateur de l’interprète.

Ce développement ravive l’utopie d’une écriture législative parfaite qui permettrait de réduire tout arbitraire interprétatif en assurant une prévisibilité intégrale lors de l’application. Il crée un nouveau besoin : celui de concevoir la loi dans la logique de son application robotisée en réduisant les ambiguïtés dues au langage naturel, en précisant les flous stratégiques, en tendant à l’univocité des termes utilisés et à la complétude de l’objet à réguler.

Sous l’influence de l’intelligence artificielle, l’écriture de la loi digitale du futur pourrait même en transformer la nature. De générales et abstraites, les règles statiques classiques pourraient devenir dynamiques et personnalisées en s’adaptant continument au contexte spécifique de leurs destinataires. Elles pourraient se réviser automatiquement en fonction des impacts automatiquement constatés, conçues et rédigées à l’aide de robots.

La loi digitale deviendra-t-elle alors une machine à gouverner ?

« L’application du droit par ordinateur », telle qu’esquissée en droit suisse par Paul-Henri Steinauer en 1975 déjà, devient peu à peu une réalité : décisions administratives automatisées, contrats « intelligents », résolution de litiges en ligne, collecte automatisée des données de base, etc. Cette automatisation fait apparaître un besoin : celui de disposer d’un corpus de règles de droit conçu de manière logique, précise, cohérente et complète. En effet des lois obsolètes, incohérentes, obscures, ambigües et confuses ne se laissent pas automatiser. Elles doivent être réécrites. Au lieu de continuer à s’évertuer à codifier les règles en langue naturelle, pourquoi désormais ne pas les coder directement en des termes directement interprétables par les machines ?

Le code (informatique) deviendrait la référence juridique de base et sa codification (en langage naturel) la vulgarisation du code informatique pour le public. L’écriture même de la loi en sortirait révolutionnée : le codage se substituerait à la codification, avec des potentialités et des conséquences potentiellement vertigineuses.

Une telle écriture s’écarte pourtant de celle du langage naturel. Pour qu’une loi puisse être appliquée robotiquement le plus aisément possible, elle doit être littéralement capable de « programmer » la décision d’application. Son écriture doit obéir dès lors au plus près aux règles de la logique formelle. On retrouve là l’ancien projet de concevoir le droit de manière mathématique et logique, gage d’une application syllogistique prévisible : le modèle géométrique, cher à Leibniz notamment, qui a pourtant montré ses limites (Frydman 2013, 281 ; Champeil-Desplats 2014, 59 ; sur le tournant mathématique du droit, cf. Desrameaux 2018, 32 ss ; cf. ég. d’autres réf. in: Flückiger 2019, 41 ss et 56 ss). Dans ce modèle, la loi doit revêtir les propriétés classiques des systèmes logiques formels : l’univocité, la cohérence et la complétude comme le résume Benoît Frydman (Frydman 2013, 272). Hans Kelsen voyait dans le premier de ces postulats – celui de « formuler des normes de droit qui soient le plus univoques possible, ou tout au moins de les formuler de telle façon que les équivoques et ambiguïtés inévitables soient réduites à un minimum » – le gage du « plus haut degré de sécurité juridique » (Kelsen 1962, 463).

Le codage informatique d’une loi met immédiatement en lumière les ambiguïtés propres au langage naturel. Aussi n’est-il pas étonnant que les premières tentatives, voici plusieurs décennies déjà, consistaient à analyser préalablement les règles légales sous l’angle de la logique formelle afin de reconstruire la « règle parfaite », fondement de la formule de base pouvant alors être traduite en langage électronique. La logique formelle fournirait une véritable « lame de rasoir » pour la rédaction des textes juridiques (Allen 1957) :

« Une grande partie des litiges fondés sur des textes écrits […] peuvent être attribués au fait que le rédacteur n’a pas expliqué clairement son sens. Souvent, bien sûr, certains points peuvent être volontairement laissés ambigus, mais fréquemment le litige est dû à une ambiguïté involontaire qui aurait pu être évitée si le rédacteur avait clairement exprimé ce qu’il voulait dire. […] une nouvelle approche légistique, utilisant certaines notions élémentaires de logique symbolique, peut contribuer grandement à éliminer une telle ambiguïté involontaire. » (Allen 1957, 833, traduction personnelle).

Ce processus de formalisation a été très bien décrit en droit suisse par Paul-Henri Steinauer qui suggérait une « analyse logique des phrases légales » pour permettre la « construction de la règle parfaite », suivie par l’élaboration de la « formule de base », sa « traduction en langage électronique », sa « minimisation » puis l’élaboration de la « formule finale » permettant de créer le « schéma de programme » pour la machine (Steinauer 1975, 166). Cet auteur a testé cette réécriture sur la loi genevoise sur la taxe professionnelle communale de 1887 dans sa teneur de 1974 (Steinauer 1975, 192 ss).

On retrouve très tôt dans la doctrine états-unienne ce procédé analytique qui impose une « normalisation » des textes juridiques1. Le débat fut vif dès l’origine entre ceux qui estimaient que le droit devait être récrit pour les besoins de la machine et ceux qui redoutaient une rigidification de la discipline. La « First National Law and Electronics Conference » qui s’est tenue à Lake Arrowhead en Californie en 1960 a posé les bases de la problématique, y compris la prédictibilité des décisions de justice (Chasalow 1961, 33 s. ; Loevinger 1960). Les premiers voyaient dans la logique formelle un langage artificiel créé pour faciliter la communication précise du message juridique2. Un pionnier de la linguistique informatique suggérait ainsi de standardiser la langue du droit et d’établir une structure théorique et philosophique solide pour assurer la cohérence du langage des juristes3. Il fut immédiatement contredit : le droit n’a pas à se plier aux exigences des machines au risque d’imposer, sinon, une structure philosophique rigide de nature à limiter son évolution et sa flexibilité4.

Faisant fi de la critique, les tentatives pour transformer la loi en code exécutable se sont succédé. Ainsi en 1985 une loi a été adoptée au Tennessee sous forme « normalisée » (Gray 1985). L’expérience fit pourtant long feu « pour la raison qui peut sembler paradoxale, que plus personne ne pouvait lire ce texte trop normalisé, qui devenait incompréhensible pour un citoyen normal. » (Bourcier 1995, 138).

Si la piste de rédiger les codes de loi comme des codes informatiques a été largement oubliée dans l’intervalle par les législateurs, les administrations n’ont quant à elles pas attendu pour développer des processus de décisions automatisées ou semi-automatisées (cf. en droit allemand Guckelberger 2019 ; en droit français Cluzel-Métayer 2018), notamment en droit fiscal (cf. Braun Binder 2018) ou plus généralement dans le cadre de la cyberadministration (cf. le cadre posé par la déclaration européenne relative à la cyberadministration [Tallinn Declaration on eGovernment] du 6 octobre 2017). Ce qui paraissait futuriste en 1960 est devenu quasiment banal en 2020 si l’on songe par exemple au calcul des impôts, le sujet précisément pris comme cas d’étude par Paul-Henri Steinauer en 1975, on le rappelle. En 2016 le législateur européen a réglementé la décision individuelle automatisée dans son RGPD5 (art. 22).

En revanche, du point de vue de l’écriture, le texte de loi a résisté dans sa traditionnelle gangue en langue naturelle. Les informaticiens ont simplement dû transcrire après coup la loi en programme informatique. La loi n’est pas devenue elle-même un code informatique, et ne pourra probablement jamais le devenir. Récemment pourtant, probablement inspirée par la généralisation d’outils de programmation intuitifs utilisés notamment pour coder informatiquement les rapports contractuels afin d’en automatiser l’exécution (smart contracts), une nouvelle génération de chercheurs tente derechef de bouleverser l’écriture de la loi (on trouvera la liste la plus récente de telles expériences in: Waddington 2019, 34 ss).

On citera en dernier lieu l’administration néo-zélandaise qui vient de réfléchir au sein d’un groupe de travail à des règlements lisibles par des machines (« making government rules machine consumable ») afin d’automatiser les services et certains processus décisionnels (Waddington 2019). Constatant qu’il était difficile de produire de tels règlements si la législation et la politique publique qu’elle met en œuvre n’avaient pas été pensées dans cette optique, elle conclut à la nécessité de concevoir ceux-ci, dès l’origine, au sein d’une équipe pluridisciplinaire comprenant des analystes de politiques publiques, des rédacteurs législatifs et des développeurs informatiques (Service Innovation Lab, 4 et 29 ; Accident Compensation Better Rules Discovery Team, 6) :

« Developing the rules statements and code simultaneously, around the same table, improved the quality of the code and rules statements. And, while the team thought this approach might be more time intensive, the time taken to produce both outputs reduced. » (Accident Compensation Better Rules Discovery Team, 27 et 6 [ « Developing rules statements and code at the same time most effective »]).

Pour ce faire, ces spécialistes devraient travailler ensemble pour produire d’une part la loi, d’autre part le code informatique autour d’un pseudo-code, à savoir la description des algorithmes en langage presque naturel. Ce pseudo-code formerait la matrice de logique formelle permettant de produire d’une part le texte législatif lisible par les humains et, d’autre part, le texte exécutable par les machines :

« The teams worked to rewrite the legislation, first as ‹ pseudocode › – the rules behind the legislation in a logical chain – then as human-readable legislation and finally as software code, designed to make it far easier for public servants and the public to work out who was eligible for what outcome. In the end, the team had working code for how to digitally deliver two policies. » (Darabi 2018)

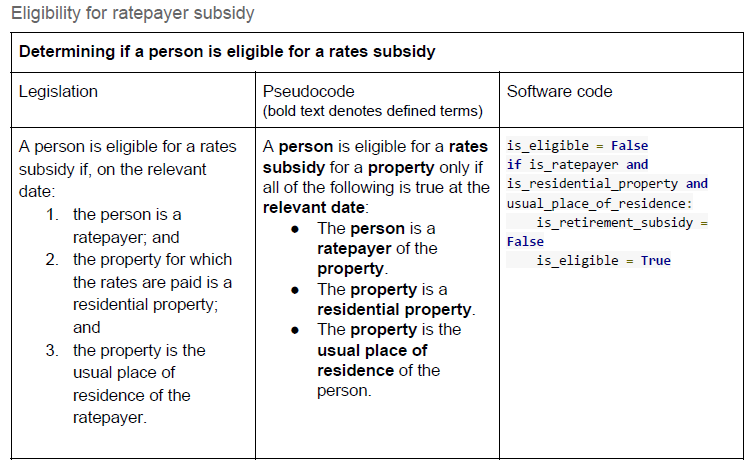

Cette conception commune devrait garantir la cohérence entre la version en langage naturel et celle en langage informatique. Les changements opérés sur une version pourraient de la sorte être répliqués de façon fiable sur l’autre. La figure suivante illustre le processus :

Eligibility for ratepayer subsidy. Source : Service Innovation Lab 22.

Cette tentative n’est à l’heure actuelle qu’au stade d’une recherche exploratoire. D’autres projets récents, mais antérieurs, partageant une ambition analogue, ne semblent pas être plus avancés dans leurs applications pratiques, voire même être au point mort. L’un de ces exemples, mené par les archives nationales du Royaume-Uni, consistait à concevoir la loi selon la méthode du langage de modèles (pattern language) (Solan 2017) dans le but de codifier et de modéliser l’architecture de la loi afin de faciliter son usage dans le cadre des données de masse (big data). L’idée était d’éditer un vocabulaire commun entre les destinataires de la loi et les personnes chargées de la rédaction de celle-ci afin d’identifier les meilleurs pratiques rédactionnelles (legislation.gov.uk/projects/big-data-for-law [30 septembre 2019] ; Flückiger 2019, 518 ss). L’autre projet, particulièrement ambitieux, visait à transformer le droit états-unien en un vaste programme informatique : le droit, expliquait son auteur, serait intrinsèquement computationnel dans la mesure où l’on doit le concevoir comme un ensemble d’algorithmes qui prescrivent la façon dont les diverses opérations relatives à son application doivent être effectuées (law.stanford.edu/projects/hammurabi [30 septembre 2019] ; cf. Flückiger 2019, 518 ss).

L’utopie de la loi parfaite est décidément bien vivace, de telle sorte que les « vieux rêves perfectionnistes d’écriture législative » – ainsi que Véronique Champeil-Desplats les qualifie (réf. cit. in: Flückiger 2019, 518) – redeviennent actuels. Gageons qu’ils seront tout aussi rapidement déçus dans le futur.

A l’origine, les premières tentatives d’écriture modélisée des lois ne visaient que les opérations facilement mathématisables et donc aisément automatisables, c’est-à-dire les rares d’entre elles qui remplissent les conditions de l’univocité, de la cohérence et de la complétude – qui sont les propriétés idéales du modèle géométrique (cf. ci-dessus ch. 2.1). Lorsque ces conditions ne sont pas remplies – typiquement en présence de règles contradictoires, de notions juridiquement indéterminées, de principes ou de buts – l’automatisation trouve ses limites (Guckelberger 2019, 364 ss, 393 ss).

Paul-Henri Steinauer en était parfaitement conscient ; l’application automatique du droit ne devrait être réservée selon lui qu’aux tâches de pure routine logique ne nécessitant aucune réflexion créatrice pleinement humaine :

« De nombreuses activités du juriste relèvent de la pure ‹ routine logique › et sont susceptibles de mécanisation. Loin de vouloir supprimer la ‹ justice vivante ›, la cybernétique se met à son service afin de la libérer de toutes les tâches qui ne font pas appel à une réflexion créatrice pleinement et exclusivement humaine. » (Steinauer 1975, 13 s.)

Dans cette veine, il prédisait que « [l]a construction de ‹ juges automates › et, à plus forte raison, de ‹ législateurs automates › n’entr[ait] […] pas en ligne de compte dans un avenir proche, bien que cela soit ‹ probablement faisable › » (Steinauer 1975, 13).

Trois décennies plus tôt, dans un article pionnier paru en 1948, Dubarle avait étendu la problématique à la « machine à gouverner » se demandant si « la manipulation mécanique des réactions humaines » ne devait pas créer un jour « le meilleur des mondes » :

« Une des perspectives les plus fascinantes ainsi ouvertes est celle de la conduite rationnelle des processus humains, de ceux en particulier qui intéressent les collectivités […] Nous pouvons rêver à un temps ou une machine à gouverner viendrait suppléer – pour le bien ou pour le mal, qui sait ? – l’insuffisance aujourd’hui patente des têtes et des appareils coutumiers de la politique. […] En dépit de tout ceci, heureusement peut-être, la machine à gouverner n’est pas tout à fait pour un très proche demain. » (Dubarle 1948).

Or les développements de l’intelligence artificielle, couplés à la massification et la diversification des données captées automatiquement, remettent au goût du jour tant la machine à gouverner, le juge automate, que le législateur robotique. L’automatisation serait désormais prête à s’étendre aux activités juridiques allant au-delà de la pure routine logique, notamment aux dispositions finalisées, aux notions juridiques indéterminées, aux balances d’intérêts et autres évaluations prospectives comme l’exemple de la justice prédictive le montre, parmi d’autres6. Antoine Garapon et Jean Lassègue estiment que dorénavant l’informatisation du droit modifiera non seulement « les modes de diffusion de la loi mais plus profondément son élaboration même » (Garapon/Lassègue 2018, 13) ; l’écriture numérique inaugurerait selon eux « un nouveau régime de normativité » à même de « concurrencer le droit écrit selon les systèmes d’écriture traditionnels, alphabétiques ou autres, et [de] menacer l’ordre politique qui l’accompagnait jusqu’à présent. » (Garapon/Lassègue 2018, 14).

Si les recherches publiées en la matière semblent relever, à ce jour, de la science-fiction juridique, les conséquences sont potentiellement perturbantes. En effet de telles lois, digitalement codées, ne contiendraient plus nécessairement des règles statiques à l’image des règles actuelles ; elles pourraient s’adapter en permanence au contexte spécifique de leurs destinataires en leur adressant en temps réel des micro-directives personnalisées en fonction des données – personnelles ou non – automatiquement collectées (Casey/Niblett 2017 ; cf. pour une description critique Garapon/Lassègue 2018, 245 ; Flückiger 2019, 264 ss). Leur mise en œuvre pourrait être renforcée par des sanctions automatisées7 et leur effectivité encouragée par des procédés de respect incitatifs (nudges ; sur cet instrument, cf. Flückiger 2019, 428 ss) appelés à devenir eux-mêmes dynamiques (hypernudges)8. Appliquées à titre préventif par des mesures techno-régulatoires (Flückiger 2019, 422 ss), ces nouvelles lois digitales pourraient si besoin devenir tout simplement impossibles à violer de fait. En cas de conflit, une procédure de résolution des litiges en ligne automatisée pourrait être ouverte (Garapon/Lassègue 2018, 204). Certains auteurs imaginent même que de telles lois puissent à terme se réviser elles-mêmes en fonction des impacts automatiquement constatés, de l’évolution des techniques ou des scénarios pronostiqués (cf. les règles dynamiques de McGinnis/Wasick 2015, 1039 ss, développées in: Flückiger 2019, 56 ss). Dans ce sillage, leur rédaction pourrait être confiée à des intelligences artificielles (rulemaking by robot), impliquant d’adapter mutatis mutandis les conditions de la délégation législative lorsqu’il s’agit de textes réglementaires ( « cyberdélégation » législative ; cf. à ce sujet Coglianese/Lehr 2017, 1179 ss, discutée in: Flückiger 2019, 56 ss).

Les tentatives consistant à conférer un soubassement de logique formelle aux lois pour améliorer leur clarté rédactionnelle en vue de leur transformation en code informatique s’inscrivent dans une longue tradition philosophique : celle du droit conçu comme un modèle géométrique. Ces expériences ne sont en soi pas problématiques ; bien au contraire, puisqu’elles contribuent à une meilleure clarté législative (sur ce sujet, cf. Flückiger 2019, 547 ss). Les espoirs qu’elles suscitent en matière de rationalité seront pourtant bien rapidement douchés, puisque ces tentatives buteront exactement contre les mêmes écueils que le tournant interprétatif contemporain (tournant linguistique et modèle pragmatique de l’interprétation ; sur ce sujet, cf. Frydman 2013, 541 ss) a repérés au sein du modèle géométrique : impossible univocité, improbable cohérence et fondamentale incomplétude des termes de la loi. La loi ne sera jamais parfaite.

Quant au « meilleur des mondes normatifs » qu’espèrent les penseurs de l’intelligence artificielle appliquée à la loi digitale, s’il n’est en l’état qu’une vision dystopique heureusement fort lointaine, celle-ci reste probablement faisable. Une telle fusion entre législation, application, exécution, jugement et évaluation remettrait pourtant en cause le principe cardinal de séparation des pouvoirs et exercerait sur les individus un contrôle total en restreignant drastiquement leur autonomie décisionnelle ainsi que leur sphère privée (Flückiger 2019, 56 ss). Antoine Garapon et Jean Lassègue mettent en garde contre cette loi digitale en soulignant que « [l]’automatisme est le contraire de la politique en démocratie, laquelle se construit sur fond de discussion et d’une indétermination radicale. » (Garapon/Lassègue 2018, 217 et 292).

La raison législative du futur consistera dès lors à allier le plus harmonieusement possible l’intelligence naturelle à l’artificielle afin d’éviter que la seconde n’aliène la première (Flückiger 2019, 56 ss). Les bases constitutionnelles, légales et conventionnelles pertinentes restent à anticiper9.

Telle était déjà la conclusion de Paul-Henri Steinauer en 1975 :

« Il est rare que la juridiction échappe complètement à l’irrationnel : morale, religion, habitudes, sentiments y jouent parfois un rôle important. Il faut dès lors, à tout le moins, se demander si le respect des droits fondamentaux de la personne n’exige pas que l’application du droit soit exclusivement le fait de l’homme et/ou si l’utilisation d’ordinateurs dans ce but ne devrait être décidée par le législateur lui-même (au besoin par une disposition constitutionnelle). » (Steinauer 1975, p. 248).

Alexandre Flückiger, Professeur à la Faculté de droit de l’Université de Genève, courriel : Alexandre.Flueckiger@unige.ch. L’auteur tient à remercier Simon Junod, assistant au Centre d’étude, de technique et d’évaluation législatives (CETEL) de la Faculté de droit de l’Université de Genève, pour la relecture et la mise en page de la présente contribution.

- Accident Compensation Better Rules Discovery Team, 2019, Exploring Machine Consumable Accident Compensation Legislation: Lessons for a structural rewrite of the AC Act and opportunities to make it machine consumable.

- Allen, Layman E., 1957, Symbolic Logic: A Razor-Edged Tool for Drafting and Interpreting Legal Documents, Yale Law Journal, vol. 66, p. 833 ss.

- Allen, Layman E./Engholm, C. Rudy, 1978, Normalized Legal Drafting and the Query Method, J. Legal Educ. 29, p. 380 ss.

- Bourcier, Danièle, 1995, La décision artificielle : le droit, la machine et l’humain, Paris.

- Braun Binder, Nadja, 2018, Algorithmic Regulation: Der Einsatz algorithmischer Verfahren im staatlichen Steuerungskontext, in: Hill, Hermann/Wieland, Joachim (éd.), Zukunft der Parlamente, Berlin, p. 107 ss.

- Casey, Anthony J./Niblett, Anthony, 2017, The Death of Rules and Standards, Indiana Law Journal, vol. 92/4, p. 1401 ss.

- Champeil-Desplats, Véronique, 2014, Méthodologies du droit et des sciences du droit, Paris.

- Chasalow, Irwin, 1961, The First National Law and Electronics Conference, The American Behavioral Scientist, mars 1961, p. 31 ss.

- Cluzel-Métayer, Lucie, 2018, Calculer : l’influence des algorithmes sur l’édiction des décisions administratives, in: Association française pour la recherche en droit administratif (dir.), Les méthodes en droit administratif, Paris, p. 243 ss.

- Coglianese, Cary/Lehr, David, 2017, Regulating by Robot: Administrative Decision Making in the Machine-Learning Era, The Georgetown Law Journal, vol. 115, p. 1147 ss.

- Darabi, Anoush, 2018, New Zealand explores machine-readable laws to transform government, apolitical.co, disponible sur apolitical.co/solution_article/new-zealand-explores-machine-readable-laws-to-transform-government (dern. consult. 30 septembre 2019).

- Desrameaux, Alexandre, 2018, L’empire de la technique au royaume du droit, in: Desrameaux, Alexandre/Colonna d’Istria, François (dir.), Penser la technique juridique, Paris, p. 25 ss.

- Dubarle, Dominique, 1948, Vers la machine à gouverner : La manipulation mécanique des réactions humaines créera-t-elle un jour le « meilleur des mondes » ?, Le Monde, édition du 28 décembre 1948.

- Flückiger, Alexandre, 2019, (Re)faire la loi : traité de légistique à l’ère du droit souple, Berne.

- Frydman, Benoît, 2013, Le sens des lois : histoire de l’interprétation et de la raison juridique, 3e éd., Bruxelles.

- Garapon, Antoine/Lassègue, Jean, 2018, Justice digitale : révolution graphique et rupture anthropologique, Paris.

- Gasser, Urs/Drolshammer, Jens, 2015, The Brave New World of (Swiss) Law: Contours of a Framework and Call for a Strategy to Shape Law’s Digital Revolution, in: Recht im digitalen Zeitalter: Festgabe Schweizerischer Juristentag 2015 in St. Gallen, Saint-Gall, p. 83 ss.

- Gray, G. B., 1985, Statutes enacted in normalized form: The legislative experience in Tennessee, in: Walter, Charles (éd.), Computer Power and Legal Reasoning, Saint-Paul, p. 467 ss.

- Guckelberger, Annette, 2019, Öffentliche Verwaltung im Zeitalter der Digitalisierung: Analysen und Strategien zur Verbesserung des E-Governments aus rechtlicher Sicht, Baden-Baden.

- Kelsen, Hans, 1962, Théorie pure du droit (trad. Charles Eisenmann), Paris.

- Loevinger, Lee, 1960, The Element of Predictability in Judicial Decision Making, in: Proceedings First National Law and Electronics Conference, p. 249 ss.

- Luminati, Michele/Contarini, Filippo, 2019, Das Richterbild in der Schweiz: richterliche Unabhängigkeit auf dem Prüfstand, RDS II, p. 201 ss.

- Paychère, François, 2018, « Da mihi factum, dabo tibi jus »: mythe et réalité(s) du robojuge, Justice – Justiz – Giustizia vol. 4.

- McGinnis, John O./Wasick, Steven, 2015, Law’s Algorithm, Florida Law Review, vol. 66, iss. 3, p. 991 ss.

- Rechsteiner, David, 2018, Der Algorithmus verfügt, Jusletter.

- Service Innovation Lab (LabPlus), 2018, Better Rules for Government: Discovery Report, disponible sur digital.govt.nz/dmsdocument/95-better-rules-for-government-discovery-report (dern. consult. 30 septembre 2019).

- Solan, Lawrence, 2017, Patterns in Language and Law, International Journal of Language & Law, vol. 6, p. 46 ss.

- Steinauer, Paul-Henri, 1975, L’informatique et l’application du droit : le rôle du juriste dans l’élaboration d’un programme d’application du droit par ordinateur, Fribourg.

- Waddington, Matthew, 2019, Machine-Consumable Legislation: A Legislative Drafter’s Perspective – Human v Artificial Intelligence ?, The Loophole, Journal of the Commonwealth Association of Legislative Counsel, juin 2019, p. 21 ss.

- Yeung, Karen, 2017, Hypernudge: Big Data as a Mode of Regulation by Design, Information, Communication & Society, vol. 20, iss. 1, p. 118 ss.

- 1 « Normalized legal drafting is a mode of expressing ideas in statutes, regulations, contracts, and other legal documents in such a way that the syntax that relates the constituent propositions is simplified and standardized. » (Allen/Engholm 1978, 380).

- 2 « Lawyers should look upon symbolic logic as an artificial language created to facilitate the precise communication of ideas » (Chasalow 1961, 33).

- 3 « Dr. David Hays […] suggested that the law put its language in neat, standard form. […] [L]awyers need first to establish a sound theoretical, or philosophical, structure to provide consistency in their language. » (Chasalow 1961, 32).

- 4 « Professor Addison Mueller said that […] the language of the law [should not] be altered to accomodate the needs of the machines. This was not a rejection of language alteration for the sake of improvement, but rather a denial of any rigid philosophical structure which would, by demanding conformity, constrict the growth and flexibility of the law. » (Chasalow 1961, 32).

- 5 Règlement (UE) 2016/679 du 27 avril 2016 relatif à la protection des données, JO L 119 du 4 mai 2016, p. 1.

- 6 Sur le juge comme « Subsumtionsautomat », cf. Luminati/Contarini 2019, 268ss ; comme « robojuge », cf. Paychère 2018.

- 7 « Im Kanton St. Gallen werden beispielsweise Strafbefehle für Ordnungsbussen, welche nicht innert ordentlicher Frist bezahlt wurden und Bagatellübertretungen nach Strassenverkehrsrecht weitgehend automatisiert vorbereitet. » (Rechtsteiner 2018, sur les sanctions pénales ou administratives automatisées).

- 8 Cf. Flückiger 2019, 264 ss ; sur la notion d’hypernudge, cf. Yeung 2017, cit. in Flückiger 2019, 264 ss : « unlike the static Nudges popularised by Thaler and Sunstein […] such as placing the salad in front of the lasagne to encourage healthy eating, Big Data analytic nudges are extremely powerful and potent due to their networked, continuously updated, dynamic and pervasive nature (hence ‘hypernudge’). » (Yeung 2017, Abstract).

- 9 Cf. par exemple la Résolution du Parlement européen du 12 février 2019 sur une politique industrielle européenne globale sur l’intelligence artificielle et la robotique (2018/2088(INI)), ou la Déclaration du Comité des Ministres du Conseil de l’Europe sur les capacités de manipulation des processus algorithmiques du 13 février 2019.