Table des matières

Il y a un vrai paradoxe avec l’évaluation participative (EP). D’un côté, la question de la participation des parties prenantes à l’évaluation est presque aussi ancienne que l’évaluation (Brisolara 1998 ; Ridde 2006, 23). D’autre part, elle n’en finit pas d’être présentée comme une solution nouvelle aux problèmes récurrents de l’évaluation des politiques publiques.

Dès les années 1970, il est possible de voir des évaluations qui donnent un rôle important aux parties prenantes (Cousins et Whitmore 1998). Dans les années 1980 et 1990 s’est développé un très large corpus d’arguments en faveur de la participation à l’évaluation, et sur les façons d’organiser cette participation. Les démarches participatives ont pris leur essor en Europe dans les années 1990, d’abord à l’échelle de projets et de programmes, avant de trouver leur chemin dans les politiques nationales d’évaluation (dès 1991 en France) ainsi que dans les principes et dans les standards de nombreuses sociétés d’évaluation de par le monde.

Mais alors, pourquoi l’EP est-elle régulièrement présentée comme une innovation, malgré 50 ans de présence1 ? Le fait est que, si la participation est bien présente dans les discours, elle l’est rarement dans les actes. En nous appuyant sur notre expérience de praticien de l’EP, en France et en Europe, nous identifions trois raisons à cela :

- L’ambiguïté qui entoure le terme d’EP fait qu’il est souvent difficile, au premier abord, de savoir à quoi on a affaire.

- La deuxième raison est que l’EP est dangereuse pour les acteurs en place, elle bouscule les cadres, la façon de faire des politiques publiques.

- Et la troisième, enfin, est que les EP, même avec les meilleures intentions du monde, restent difficiles à mettre en œuvre, car le contexte, le choix des participant·es, le hasard jouent un rôle important dans leur réussite. Au final, l’EP n’est pas un produit garanti et elle peut aboutir à des déceptions (Baron et Monnier 2003).

Faut-il pour autant se décourager ? La participation est au contraire une des clés pour que l’évaluation reste d’actualité dans la décennie à venir, dans la mesure où elle parvient à faire face à certains enjeux de fond, que nous discuterons en conclusion.

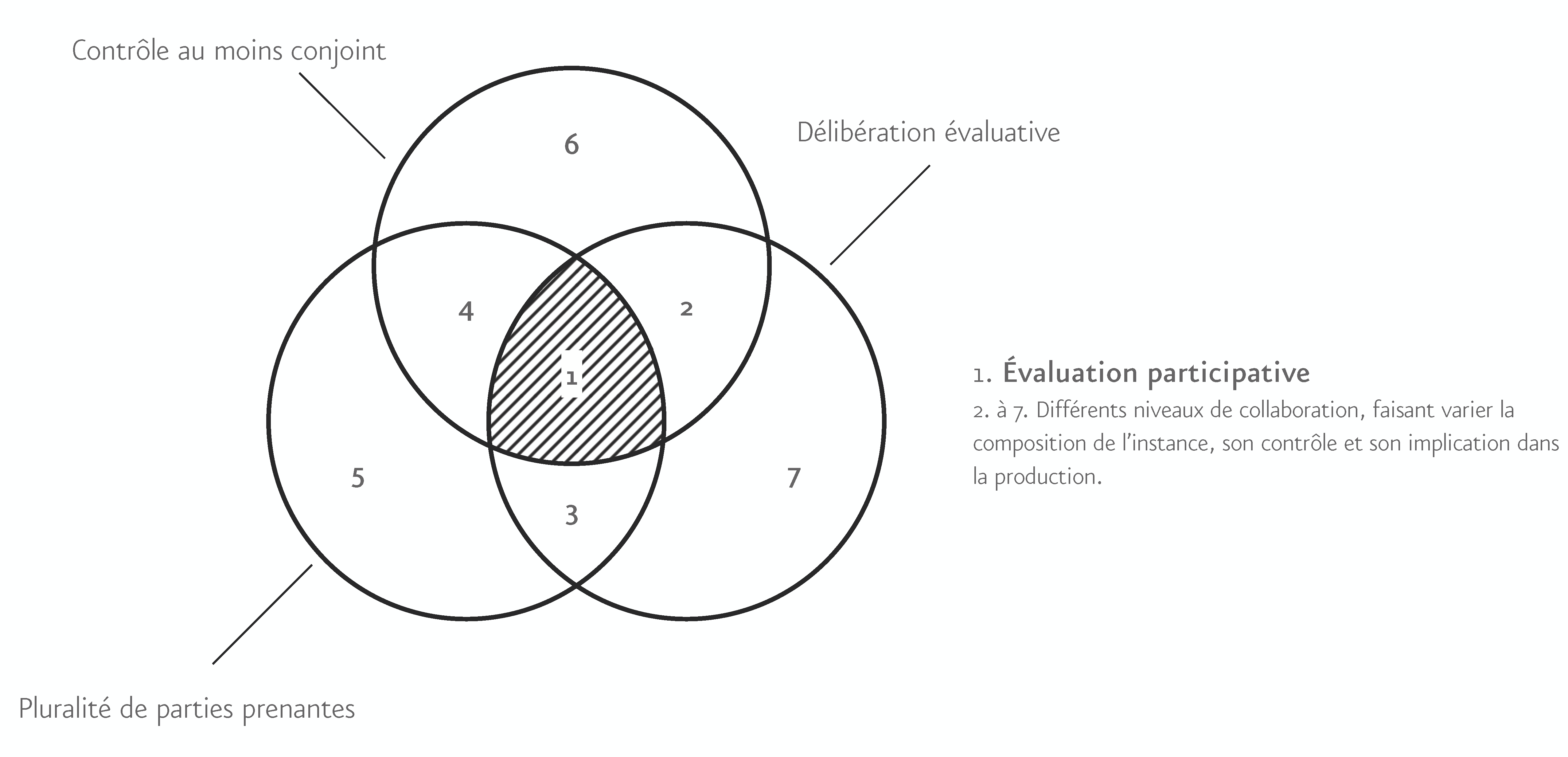

Mener une EP, ce n’est pas simplement impliquer des parties prenantes dans l’évaluation. J. Bradley Cousins et Elizabeth Withmore ont proposé trois critères pour distinguer l’EP d’autres démarches impliquant les parties prenantes (Cousins et Whitmore 1998 ; pour des précisions sur ces critères et leur opérationnalisation : Marchand 2018 ; Ridde 2006) : le contrôle du processus évaluatif, la sélection des parties prenantes et l’étendue de la participation. En les appliquant à notre pratique professionnelle de l’évaluation, cela donnerait la définition suivante :

- l’EP donne à une instance pluraliste un rôle décisionnel dans la conduite technique de l’évaluation (conception, pilotage, choix relatifs à la mise en œuvre, à la collecte, aux rendus…). Ce contrôle peut être total ou partagé avec les commanditaires et l’équipe d’évaluation ; il peut porter sur tout ou partie des étapes présentées ci-dessus.

- par pluraliste, on entend que cette instance doit inclure d’autres points de vue que ceux des décideurs, des financeurs ou des opérateurs, et notamment ceux des acteurs de la mise en œuvre, des publics affectés par l’action publique, ou concernés en tant que citoyen·nes.

- cette instance doit participer à la production de l’évaluation et de ses cadres, a minima en influant sur la façon dont l’intervention va être jugée, au regard de quelles valeurs, quels critères (« qu’est-ce qui compte, qu’est-ce qui est important ? »), et sur la réponse apportée par l’évaluation aux questions qui lui sont posées.

La dimension participative ne peut pas se déduire simplement des caractéristiques initiales d’une évaluation : elle se juge rétrospectivement. Ainsi, le contrôle peut être donné à l’instance, pris en cours d’exercice… ou s’estomper, s’il n’en est pas fait usage. Le pluralisme tient au maintien de la participation dans l’évaluation, et à la capacité des acteurs à exprimer des points de vue différents ; il peut être perdu lorsqu’un acteur prend le dessus (Chanut 2002, 12). Et enfin, il ne suffit pas aux participant·es de s’exprimer ou de témoigner sur les éléments constitutifs de l’évaluation. L’instance doit être un lieu de délibération évaluative, c’est-à-dire un lieu d’échange raisonné d’arguments dans lequel tou·tes les participant·es ont voix au chapitre. Ce processus leur permet de s’informer, mais aussi d’évoluer dans leurs préférences, dans ce qui compte pour eux, et donc d’aboutir à un jugement plus fondé.

Puisqu’il s’agit d’une évaluation, cette délibération doit :

- être guidée par un souci d’aboutir à un jugement s’appuyant sur des données probantes, récoltées au cours de l’évaluation ;

- porter sur les conséquences attendues ou non de l’intervention dans le monde réel, et pas uniquement sur son processus ou sur ses bénéfices ou ses inconvénients en théorie ;

- viser à l’amélioration de l’action publique et, in fine, à l’intérêt général.

Sont exclus de ce fait des dispositifs tout à fait honorables, mais qui sont collaboratifs plutôt que participatifs, c’est-à-dire qu’ils engagent les parties prenantes comme sources d’information, d’analyse, de compréhension, mais ne leur donnent pas de contrôle sur le processus et ses productions2, ainsi que des dispositifs participatifs qui peuvent faire de l’évaluation un excellent prétexte pour organiser des échanges (conférences citoyennes, jurys citoyens, etc.), mais qui ne sont pas évaluatifs, même s’ils en portent le nom3.

La Figure 1 ci-dessous synthétise ces éléments de définition :

Figure 1 : Définition au regard de trois caractéristiques de l’instance d’évaluation

Au-delà de ces trois conditions réunies, il y a encore une très large diversité d’EP, qui peuvent être très différentes dans leurs caractéristiques. En particulier, on distinguera des évaluations qui réunissent une grande variété de parties prenantes, avec l’objectif de les faire échanger, et des évaluations qui réunissent un type particulier de parties prenantes (des travailleur/ses de première ligne, des publics concernés) de façon à ce qu’elles puissent délibérer entre elles et se faire entendre.

Pourquoi se livrer à tous ces efforts ? Les EP, en tant que dispositifs participatifs, servent généralement trois principaux objectifs avoués (Bacqué et Sintomer 2001 ; Blondiaux 2004), qui sont l’amélioration de l’action publique ; le « vivre-ensemble », le fait d’intéresser les gens, les parties prenantes à l’intérêt collectif ; et puis la volonté de suppléer à nos systèmes démocratiques, voire les supplanter à terme, en changeant les rapports de pouvoir de nos sociétés. On pourrait ajouter qu’il y aussi des objectifs inavouables, qui peuvent relever de la communication, de la « pédagogie4 », ou du clientélisme.

En appliquant ces cadres à l’EP, on peut avoir deux approches (Cousins et Whitmore 1998) :

- Soit on voit la participation d’abord comme un moyen de produire de meilleures évaluations, plus pertinentes, plus crédibles (Houle 2018 ; et voir J. Leca, cité dans Lascoumes, Varone, et Pons 2006, 22), plus légitimes (Monnier et Duran 1992, 123‑24) et donc plus utiles et plus utilisées : c’est la vision « pratique » de l’EP (Cousins 2003 ; Marchand 2018 ; Plottu et Plottu 2009 ; Ridde 2006).

- Soit ce qui compte, c’est de donner à des parties prenantes, en particulier celles qui n’ont pas la parole habituellement, les moyens de se faire entendre. L’évaluation les aide à renforcer leurs connaissances, les aide à mieux se comprendre, à travailler ensemble, voire à gagner en estime de soi, en conscience critique, bref, en pouvoir d’agir5. C’est la logique « transformationnelle » de l’EP.

Voilà pour la théorie ; mais dans les faits, qu’en est-il ? Nous rapportons ci-dessous trois exemples très différents, dans lesquels nous avons été impliqués, et qui rendent compte de la diversité des EP.

(1) Dans l’évaluation d’un dispositif régional visant à soutenir les projets des habitants de quartiers défavorisés dans une optique de cohésion sociale, une démarche assez classiquement collaborative est d’abord menée, visant à identifier les apports de ces projets pour les habitants à travers une série d’études de cas dans les territoires concernés. L’équipe d’évaluation conclut à un dispositif apprécié, mais peu connu, peu employé et aux conséquences largement intangibles. Elle interroge le maintien du dispositif. Puis, un panel citoyen, représentatif de la population régionale, est recruté pour répondre à un certain nombre de questions évaluatives. Accompagnés par la même équipe, les citoyen·nes sont formés et leur réflexion est alimentée par les collectes et analyses réalisées dans l’évaluation initiale. Ils interrogent des acteurs (experts, agents, travailleurs sociaux...) qu’ils ont sélectionnés au préalable pour rédiger leur avis citoyen. Dans celui-ci, ils n’hésitent pas à s’affranchir des questions évaluatives et affirment que la cohésion sociale n’est pas seulement un enjeu dans les quartiers défavorisés, mais pour tous les territoires de la région. Ils font ainsi prévaloir la pertinence du dispositif sur son efficacité. Lors de la restitution, l’élu s’engage auprès des citoyens et citoyennes et devant les médias locaux à prendre en compte leur avis. Ils sont invités un an après à constater les avancées.

(2) Pour l’évaluation des transports urbains d’une agglomération, une instance pluraliste est réunie. Elle inclut des élus, des agents de la collectivité commanditaire et d’autres collectivités concernées et des associations représentant différentes catégories d’usagers. Les questions évaluatives, assez vagues, sont fixées dans le cahier des charges. Lors de la première réunion de l’instance, celle-ci discute et amende le référentiel, mais à la marge. Pour la Direction Transport, cette évaluation n’est pas vraiment nécessaire : « tout va bien ». Des entretiens exploratoires avec des acteurs locaux relèvent cependant une série d’enjeux qui méritent d’être creusés. Le commanditaire les minimise, mais les parties prenantes externes font valoir que ces sujets leur importent, ce qui déclenche des analyses approfondies. La présentation des constats, puis des conclusions donne lieu à des débats d’interprétation très vifs, mais constructifs : in fine, le commanditaire décide de reprendre à son compte le jugement évaluatif (plutôt que d’en laisser la responsabilité à l’instance ou à l’équipe d’évaluation), le considérant comme légitime et comme une base future de discussion avec les parties prenantes. Celles-ci expriment en effet leur souhait de poursuivre les échanges avec le commanditaire sur la base de l’évaluation. Le président de l’agglomération, attaqué par ses opposants politiques sur les résultats de l’évaluation, rétorque que personne ne l’avait obligé à mener une évaluation ; et que les résultats nuancés présentés sont le témoin de la capacité de son administration à se remettre en question.

(3) L’État français met en place une expérimentation d’actions collectives de l’Inspection de travail (IT) visant, par une action massive sur un territoire donné, à améliorer significativement la situation des salarié·es dans un domaine d’intervention, par exemple l’exposition à l’amiante sur les chantiers. C’est un changement considérable dans la pratique professionnelle de l’IT, qui travaille par entrée territoriale plutôt que thématique. Il est inenvisageable, dans la culture de cette administration, qu’une personne extérieure puisse venir juger du bien-fondé ou des conséquences de leur action. Aussi, bien que la commande initiale soit assez modeste (mise en place d’indicateurs, essentiellement), le commanditaire et l’équipe d’évaluation s’accordent pour mettre en place une démarche dans laquelle ce sont les membres de l’Inspection eux-mêmes qui vont concevoir leur dispositif d’évaluation et le mettre en œuvre, via un processus de formation-action en parallèle des premières phases de l’expérimentation. Pour chaque action collective6, ils élaborent la théorie du changement des actions collectives, posent leurs questions d’évaluation et construisent des outils de collecte. En fin d’expérimentation, certains mandateront un prestataire extérieur pour réaliser une collecte supplémentaire. Le rapport est rédigé par un membre de l’IT, accompagné par un évaluateur, et discuté collectivement avec les collègues. Ces évaluations sont formatrices pour les équipes et leur donnent du poids supplémentaire pour s’affirmer face aux directives de leur ministère. Localement elles sont utiles pour améliorer les actions à venir. Mais elles sont difficiles à essaimer hors des territoires initialement volontaires et sans le soutien d’un évaluateur extérieur pour les accompagner.

Le tableau ci-dessous présente une analyse comparée des trois cas au regard des éléments de définition de l’EP et de ses conséquences.

Tableau 1 : Analyse comparée des trois cas

| Cas | (1) cohésion | (2) transports | (3) travail |

| Pluralité des parties prenantes | Panel citoyen | Décideurs, opérateurs, autres collectivités, représentants des usager·es | Membres de l’IT impliqués dans les actions |

| Contrôle | En théorie cadré par une lettre de mission, mais les citoyen·nes sont allés au-delà | En théorie donné à l’instance, affirmé par l’instance en cours d’évaluation | En théorie non, mais pris par les IT pour rendre l’évaluation possible |

| Délibération évaluative | À travers un processus de jury citoyen | Au sein de l’instance, avec un processus d’animation ad hoc | En réalisant eux-mêmes l’évaluation |

| Ambition | Pratique | Pratique | Transformationnelle |

| Apports de la dimension participative à l’évaluation | Modification des questions évaluatives, élargissement de la réflexion au territoire régional, priorisation du registre de la pertinence Obligation pour le commanditaire de rendre compte de ses décisions post-évaluation | Identification commune d’enjeux collectifs, appropriation partagée du diagnostic et accord sur le jugement Forte crédibilité de l’évaluation, base légitime pour poursuivre les échanges et produire une politique partagée | Explicitation des hypothèses de la théorie du changement Accès au terrain et aux interprétations des acteurs (impossible avec un évaluateur externe) Crédibilité de l’évaluation pour les autres membres de l’IT |

| Apports pour les participant·es | Meilleure perception de l’action publique, volonté de poursuivre l’implication citoyenne | Meilleure compréhension des points de vue des autres parties prenantes. Pour les associatifs, décision d’agir par eux-mêmes sans attendre la collectivité. Pour les élus, élément de crédibilité envers le grand public | Acquisition de compétences pratiques. Construction d’une posture évaluative des membres de l’IT très différente de leur posture « légale » habituelle. Outil de construction d’un collectif. |

Si l’on s’en tenait à ces promesses et à ces exemples, l’EP devrait être largement répandue ; sauf que ce n’est pas le cas : elles restent peu nombreuses. Il y a quelques années, la Société française d’évaluation s’était penchée sur un échantillon de 224 évaluations pour en analyser le mode d’association des parties prenantes. Sur ces 224, les destinataires de l’action publique étaient associées, d’une manière ou d’une autre, dans 131, soit 58 %. Ils étaient en situation de codécision sur le contenu de l’évaluation dans 7 d’entre elles, ce qui représente 3 % de l’échantillon initial7.

Il ne s’agit pas de dresser un tableau trop négatif. La plupart des personnes chargées d’évaluation reconnaissent l’importance d’impliquer les parties prenantes (Mathison 2005, citée par Ridde 2006), et cela paraît être le cas aussi du côté des commanditaires. Nous avons passé le stade où l’on pouvait considérer l’évaluation comme un tête-à-tête entre une instance de décision et une équipe d’évaluation neutre, objective et pétrie d’intérêt général. Dans notre expérience, les commanditaires d’évaluation acceptent de plus en plus d’aller au-delà de la collecte d’information auprès des parties prenantes. Inviter des personnalités extérieures au comité de pilotage est reconnu comme un gage de crédibilité, tout comme les ateliers avec les cibles de l’action publique, les destinataires. Tout cela n’est plus, en aucune façon, une innovation, et doit être reconnu comme la normalité, à laquelle il est fait exception quand les circonstances l’exigent.

Sauf que c’est cela aujourd’hui que les commanditaires désignent comme étant des EP. Ainsi, le flou qui entoure ce terme permet d’éviter de trop réfléchir à ses implications8. Dans notre expérience, seules quelques collectivités, administrations ou associations très engagées, avec souvent une culture antérieure de l’évaluation ou de la participation, demandent des EP en connaissance de cause. Ailleurs, les décideurs craignent souvent de perdre le contrôle sur le processus, à raison d’ailleurs, comme dans l’exemple de l’évaluation citoyenne (1), qui oblige un décideur à se positionner sur un sujet non anticipé, ou celle des transports urbains (2) qui dote les parties prenantes d’une base solide pour demander des changements dans la politique menée par la collectivité. Sauf que cette perte de contrôle a contribué à la crédibilité de l’évaluation dans les deux cas, ainsi qu’à son utilité.

Si nous voulons vraiment tirer les bénéfices de l’EP, il faut sortir de ce flou. À court terme, nous avons en tant qu’évaluateurs/trices une responsabilité pour utiliser la « zone d’autonomie » que ménage l’évaluation et pousser le curseur vers plus de participation lorsque c’est possible et pertinent (Delahais et Devaux-Spatarakis 2018). Cependant, pour que ce choix soit légitime, il doit être partagé et motivé : les commanditaires doivent pouvoir comprendre ce que signifie réellement la participation, ses conséquences concrètes (partage du contrôle, ouverture, organisation de la délibération, etc.), mais aussi ce qu’elle permet pour l’évaluation et l’action publique. C’est ce qui s’est passé dans l’évaluation (3), dans laquelle nous avons convaincu le commanditaire de donner tout pouvoir aux IT sur le contenu de l’évaluation, persuadé que c’était la seule façon d’éviter qu’ils ne boycottent le processus, et que les évaluations aillent à leur terme et soient utiles.

À plus long terme, la capacité des décideurs à prendre des risques ne devrait plus être un critère pour lancer une EP (Clot 2015). Les scénarios catastrophes sont possibles, mais ils sont rares9. Il y a aujourd’hui une habitude à prendre, qui passe par des procédures institutionnelles, mais aussi une « routine » à trouver pour que les dimensions de la participation ne soient plus analysées comme des risques, mais comme des ingrédients dont le dosage varie selon le contexte et les besoins.

Dernier point, et non des moindres : il n’est pas facile de mener à bien une EP jusqu’au bout. Il existe deux écueils principaux : perdre de vue la participation, et perdre de vue l’évaluation. Une EP doit pouvoir tirer sa légitimité de ces deux aspects10, mais cela rend sa conduite plus complexe. La partie suivante propose de revenir sur plusieurs enjeux clés de mise en œuvre de ces évaluations.

L’EP fait le pari qu’un groupe de parties prenantes, qui ne sont pas des professionnel·les de l’évaluation, va avoir un rôle essentiel de structuration et de production de l’évaluation. Or, c’est loin d’être évident. Les membres de l’instance peuvent hésiter à prendre le contrôle sur le processus évaluatif, même s’il le leur est donné. Et la délibération évaluative est une activité exigeante. Autrement dit, il est facile de respecter les formes de l’EP en demandant son avis à l’instance, mais en ne lui donnant pas les moyens de l’exprimer.

L’évaluateur/trice qui veut réellement obtenir les bénéfices de la participation est ainsi amené à travailler sur trois fronts, et ce dans le temps restreint de l’évaluation. Il doit11 :

- faire monter en compétence les parties prenantes, à la fois sur l’évaluation et sur le sujet de l’évaluation,

- proposer aux parties prenantes des opportunités d’exercer collectivement leur contrôle sur l’évaluation, et de délibérer…

- tout en suscitant de l’intérêt et de l’engagement pour la démarche sur toute sa durée, pour que les participant·es restent mobilisés tout au long du processus.

Ces éléments prennent des formes diverses. Par exemple, les citoyen·nes de l’évaluation (1) et les membres de l’IT engagés dans l’évaluation (3) ont suivi des formations avant de démarrer, alors que pour les membres de l’instance de l’évaluation (2), nous avons préféré intégrer des éléments explicatifs sur les concepts évaluatifs au fur et à mesure du processus. Dans cette dernière évaluation, les parties prenantes n’ont pas réussi à se saisir initialement de la discussion sur les questions évaluatives : il a fallu leur fournir une nouvelle opportunité de le faire en leur fournissant une série d’enjeux potentiels, très concrets, tels que l’usage des transports collectifs par les jeunes retraités, ou encore la desserte nocturne, pour que l’instance s’affirme collectivement.

Dans l’EP, l’équipe d’évaluation doit combiner des exigences en termes de robustesse d’analyse et de qualité de la participation, ce qu’É. Monnier synthétisait sous la triple figure du méthodologue, du médiateur et du maïeuticien (1992). Cela signifie d’abord qu’elle doit avoir des compétences en matière d’animation et de conduite des échanges, voire des facilités relationnelles (Patton 2018), mais aussi qu’elle doit veiller à son positionnement, qui confine parfois à celui d’un équilibriste. Ainsi, dans l’évaluation (1), les citoyen·nes sont notamment formés à partir de notre évaluation initiale, mais ils doivent aussi aboutir à leurs propres conclusions (qui seront de fait bien différentes des nôtres) : nous devons rester neutres alors que nous avons déjà proposé un jugement.

Une autre difficulté est que la délibération participative s’exerce en grande partie sur la base du travail réalisé par l’équipe d’évaluation. Dans l’évaluation (2), un vote coloré12 est organisé en fin d’évaluation pour discuter des conclusions que nous avons formulées. Celles-ci sont volontairement tranchées pour faciliter l’expression des participant·es, mais en retour, certains d’entre eux se plaignent que nous ne sommes pas suffisamment nuancés dans nos jugements. Il faut alors dévoiler notre stratagème pour que le débat ne porte pas sur le travail de l’équipe, mais bien sur les conclusions de l’évaluation.

Un aspect essentiel de ce travail est sa dimension très pratique. L’instrumentation participative est désormais très fournie13 et représente une aide précieuse : la conférence citoyenne mise en place dans l’évaluation (1) fournissait ainsi un cadre complet pour l’évaluation. Cependant, les guides existants peuvent expliquer quels sont les objectifs ou les modalités de la participation, mais ils ne peuvent pas rendre compte du poids excessif des détails : l’arrangement des salles, la clarté des règles, la forme des outils, la façon dont ils sont présentés, l’attitude du modérateur… éléments infimes, mais qui font souvent la différence entre un moment de participation réussi et un autre raté14.

Parce que ce travail délibératif est compliqué à mener, qu’il prend du temps, qu’on ne peut pas mobiliser l’instance en permanence, souvent le choix est fait de concentrer les interactions sur des aspects clés, tels que le questionnement ou le jugement. Cela met de côté un certain nombre d’aspects techniques, notamment méthodologiques, qui sont laissés à la discrétion de l’équipe d’évaluation et du commanditaire.

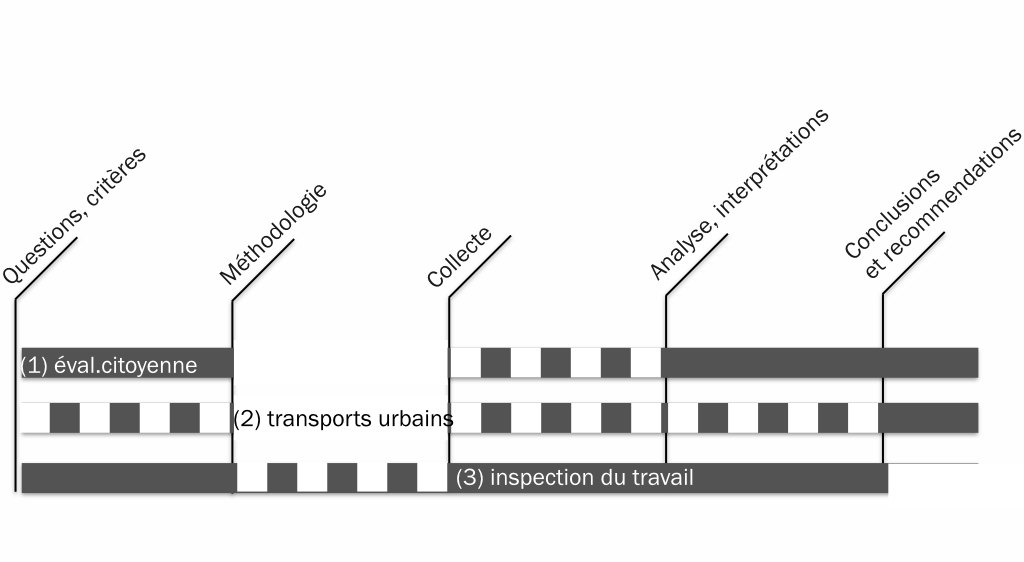

Même dans les évaluations les plus participatives, les participant·es comptent généralement sur l’équipe d’évaluation pour gérer les questions de méthode (Patton 2018, 126). Ainsi, nous avons tendance à imposer les choix techniques de collecte et d’analyse, et ces choix ne sont évidemment pas sans conséquences. La Figure 2 ci-dessous présente le niveau d’implication des parties prenantes aux différentes étapes de l’évaluation. Dans les évaluations (1) et (2), elles n’ont pas la main sur la méthodologie. Leur capacité à orienter la collecte est également limitée. Il n’y a que dans la (3) que les membres de l’IT ont plus de latitude, menant eux-mêmes leur évaluation dans une armature établie pour eux. Nous remarquons que le cadre contractuel, dans lequel se déroule un grand nombre d’évaluations aujourd’hui, est un facteur limitant de ce point de vue. La méthode est un facteur de choix entre plusieurs propositions commerciales ; le prestataire dimensionne de son côté son offre dans un budget et un calendrier précis. Au-delà des outils existants, il faudrait probablement inventer des modalités de partenariat plus souples pour que les parties prenantes puissent être impliquées plus avant dans les choix techniques de l’évaluation.

Figure 2 : implication des parties prenantes dans les différentes phases de l’évaluation (trait plein : forte implication ; pointillé : partielle ; blanc : pas d’implication)

Cette dernière section se penche sur les raisons pour lesquelles l’EP « vaut la peine » des efforts que l’on y consacre.

Et peut-être d’abord en renversant la question. Il y a aujourd’hui des situations où il n’est plus envisageable de faire une évaluation correcte et a fortiori utile si celle-ci n’est pas participative. Voici a minima deux situations de ce type :

D’abord, il y a toutes ces politiques qui sont aujourd’hui subies par leurs destinataires. Nous avons beau les appeler les « bénéficiaires », le bénéfice est plus souvent dans l’œil des pouvoirs publics que dans celui des personnes concernées, en particulier lorsqu’il s’agit de populations marginalisées : les Roms, les réfugié·es, les détenu·es, les habitant·es des quartiers défavorisés, les personnes en situation de handicap, les personnes au chômage, les personnes âgées dépendantes… Or, ces publics, ce sont ceux aussi qui ne votent pas, qui se savent peu armés pour les débats et ont abandonné l’idée de faire valoir leurs idées dans une arène publique – ou ne l’ont même jamais envisagé. Non seulement devrions-nous nous inscrire dans le principe éthique « Rien ne doit se faire pour eux sans eux » (Robert et al. 2018), mais même sans adhérer à l’aspect moral de ce principe, il faut reconnaître que nous risquons sans cette participation de perdre la capacité essentielle en tant qu’évaluateur/trice de faire un pas de côté, de réinterroger en profondeur les valeurs, les hypothèses sous-jacentes des politiques, mais aussi les nôtres – surtout quand nous avons fait les mêmes études, quand nous venons du même milieu que celles et ceux qui tiennent les leviers de la décision publique.

Mais la participation n’est pas faite que pour les publics marginalisés. Nous vivons dans des sociétés où les acteurs sont de plus en plus réflexifs. Dans la plupart des programmes sociaux, les agents qui mettent en place les actions, qui interagissent avec le public, les « travailleur·es de première ligne », sont très autonomes et ajustent les dispositifs sur le terrain au cas par cas (Dubois 2012 ; Lipsky 1981). Croit-on que les enseignant·es, les éducateurs/rices, les médecins, les membres de l’IT, lorsqu’ils sont interrogés dans une évaluation, n’ont pas un agenda, des messages qu’ils veulent faire passer (Perret 2008) ? Pense-t-on qu’ils n’ont pas un avis construit sur les politiques publiques dans lesquels ils s’inscrivent ? Pour qu’une évaluation soit réellement pertinente, il ne faut alors pas seulement les interroger, il faut définir avec eux les questions à poser, partager les cadres d’analyse tels que les théories du changement15, et collectivement interpréter les résultats.

En considérant que l’EP doit être un lieu de délibération, nous nous plaçons dans l’idée que l’évaluation doit rester le lieu d’une discussion raisonnable, dans laquelle chacun peut s’exprimer et faire valoir ses arguments, en mettant à distance ses préjugés. Le conflit est certes possible, mais il est circonscrit à des sujets donnés et il doit être possible, in fine, d’arriver à des conclusions communes. Dans l’évaluation (1), lorsque nous avons constitué le panel citoyen, consigne a été donnée au recruteur d’éviter les personnes engagées politiquement, par exemple. Nous avons souvent conseillé à des collectivités qui lançaient leur première EP de choisir des participant·es intuitu personae, qui joueraient le jeu de la participation. En ce sens, nous nous inscrivons dans la vision du modèle délibératif, théorisé dans la suite des travaux de Jürgen Habermas et John Rawls, un modèle de gouvernance dans lequel la primauté du « principe de discussion » est affirmée dans la résolution des problèmes sociaux. Dans ce modèle, ce sont l’espace public et la société civile qui identifient les problèmes sociaux, et ce sont eux également qui jugent de l’intérêt collectif d’y répondre et construisent les réponses. Ce modèle est sous-tendu par l’idée que nous partageons une culture libérale commune, qui fait que nous craignons le conflit et sommes prêts à des compromis pour l’éviter16.

Jusqu’à quel point faisons-nous fausse route ? Nous vivons à une époque où le conflit est au cœur des débats politiques, mais nous ne savons pas impliquer les acteurs qui défendent leur position par la conflictualité. Comment investir des militants de la cause animale dans une évaluation de la loi sur l’abattage des animaux ? Des féministes, des zadistes, mais aussi des religieux/ses, des nationalistes ?

Nous devons être capables de nous poser cette question. Sans prétendre à des solutions toutes faites, nous proposons ci-dessous quelques pistes pour intégrer les conflits dans nos évaluations.

D’abord, nous devons être capables de repérer les conflits. L’idée de cartographie des controverses17 est utile à cet égard. En amont de l’EP, elle permettrait de comprendre sur quoi portent les conflits et comment ils affectent la chose publique à discuter. En repérant les acteurs impliqués, elle pourrait aboutir à un changement assez radical dans les points de vue ayant voix au chapitre, et faciliter les échanges sur la base d’une meilleure compréhension mutuelle. Mais une évaluation fondée sur une cartographie des controverses ne ferait pas qu’élargir et faciliter la participation ; elle pourrait fondamentalement amender le périmètre de l’évaluation pour la faire porter sur ce qui compte vraiment (c’est-à-dire sur ce qui fait l’objet de controverses). Par exemple, une évaluation ne porterait plus sur des actions éparses visant à l’amélioration de la qualité de l’eau, mais au droit de chacun à boire une eau de qualité (et sur la façon dont l’action publique, en général, affecte ce droit). Ce point est majeur : dans notre expérience, il est compliqué d’impliquer des acteurs en conflit avec les autorités publiques, aussi parce qu’ils refusent de s’inscrire dans le cadre limité de l’évaluation pour se placer au niveau de la société dans son ensemble.

Ce travail d’enquête peut aussi être effectué par les membres de l’instance eux-mêmes, comme une façon d’élargir leurs horizons, de s’astreindre à une compréhension beaucoup plus intime des enjeux de l’action publique et de son évaluation, de prendre conscience de leur propre position dans les débats, et d’investir cette prise de conscience dans le travail évaluatif. Il existe des approches intégrées des sciences sociales s’appuyant sur une analyse des conflits (Bierschenk et Olivier de Sardan 1994), elles sont peut-être encore à inventer dans l’action publique et son évaluation. Dans les deux cas, cela plaide pour une démarche ouverte dans laquelle le cadre d’analyse est initialement large et les objets d’investigation évaluative progressivement précisés.

Une deuxième piste consiste à mettre en discussion les règles du débat lui-même. En effet, il est loin d’être sûr que les acteurs les plus conflictuels accepteraient de rentrer dans une EP. Ces groupes peuvent privilégient l’entre-soi, pour préserver leur identité et pouvoir exprimer librement leurs préoccupations. Ils peuvent aussi voir dans la participation un piège, une forme de légitimation d’une politique qu’ils désapprouvent. Il faut alors envisager que le premier sujet de la participation soit la forme qu’elle prendra, les produits qui en seront issus et la façon dont ils seront utilisés, de façon à bâtir la confiance nécessaire à la tenue d’une EP. On peut ainsi envisager des processus parallèles, continus ou ponctuels, permettant à chacun de contribuer activement à l’évaluation sans pour autant être toujours mêlés.

Une troisième possibilité renvoie à ce que l’on peut attendre de l’EP. Faut-il en effet vouloir arriver à un jugement consensuel ou à la réconciliation finale ? On peut envisager qu’une EP puisse documenter les désaccords et fasse apparaître ce qui est acceptable par l’ensemble des parties prenantes et ce qui reste du domaine du conflit et pourquoi.

Une dernière piste consisterait enfin à soutenir la réalisation d’« évaluations militantes », c’est-à-dire des évaluations portées par des groupes militants, au regard de leurs propres valeurs (Tevini 2021). Un effort de conciliation entre ces évaluations et celles menées par les autorités pourrait ensuite être mené, sous la forme de conférences de consensus, sur le modèle de ce qui a par exemple été mené en France dans le domaine de l’éducation pour rassembler différentes perspectives de recherche (Mons 2018).

4.3. Faire des évaluations participatives le point de départ de reconfigurations profondes de l’action publique

Si l’on parle d’inclusion de tous les acteurs, y compris ceux qui ne sont pas « parties prenantes » et qui subissent les politiques publiques, ou qui sont en conflit ouvert avec elles, c’est que l’EP a un potentiel important pour être motrice dans les évolutions démocratiques de nos sociétés, pour représenter une « contreforce » à la montée des populismes et lui opposer la délibération (Picciotto 2018). Ce potentiel existe, et les EP de demain peuvent aboutir à des reconfigurations plus profondes de l’action publique, la participation appelant la participation.

Nous devons prendre nos responsabilités, et nous servir des marges de manœuvre à notre disposition pour promouvoir la participation. Mais nous avons aussi besoin de trouver des allié·es, élu·es, agent·es, parties prenantes, citoyen·nes, prêt·es à essayer, expérimenter, tester : les méthodes existent, mais c’est leur mise en œuvre dans des contextes réels qui importe, et c’est là qu’il y a une expertise à développer pour des EP modestes, mais utiles. Pour reprendre le mot de C. Hutchings : « nous n’avons pas besoin de Ferraris rutilantes, mais de Fiats qui marchent tous les jours » (2016). Voilà un programme pour que la participation ne soit plus une innovation, mais devienne la nouvelle normalité.

Thomas Delahais, évaluateur, Quadrant Conseil, Paris, tdelahais@quadrant-conseil.fr.

- Bacqué, Marie-Hélène/Sintomer, Yves (2001) : Gestion de proximité et démocratie participative. Les Annales de la recherche urbaine 90(1) : 148-55.

- Barbier, Jean-Claude (2010) : Éléments pour une sociologie de l’évaluation des politiques publiques en France. Revue française des affaires sociales (1) : 25‑49.

- Baron, Gaëlle/Monnier, Éric (2003) : Une approche pluraliste et participative : Coproduire l’évaluation avec la société civile. Informations sociales (110) : 1‑7.

- Bierschenk, Thomas/Olivier de Sardan, Jean‑Pierre (1994) : ECRIS : Enquête Collective Rapide d’Identification des conflits et des groupes Stratégiques. Bulletin de l’APAD (7). http://journals.openedition.org/apad/2173 (22 octobre 2020).

- Bilodeau, Angèle/Allard, Denis/Gendron, Sylvie/Potvin Louise (2006) : Les dispositifs de la participation aux étapes stratégiques de l’évaluation. Revue canadienne d’évaluation de programme 21(3) : 257‑82.

- Blondiaux, Loïc (2004) : L’idée de démocratie représentative : enjeux, impensés et questions récurrentes. In Démocratie participative et gestion de proximité, Paris: La Découverte.

- Blondiaux, Loïc (2008) : Démocratie délibérative vs. démocratie agonistique ? Raisons politiques n° 30(2) : 131‑47.

- Blondiaux, Loïc/Sintomer, Yves (2002) : L’impératif délibératif. Politix 15(57) : 17‑35.

- Bourgeois, Isabelle/Hurteau, Marthe (2018) : L’implication des parties prenantes dans la démarche évaluative : facteurs de succès et leçons à retenir. Revue canadienne d’évaluation de programme 33(2) : 1‑11.

- Brisolara, Sharon (1998) : The History of Participatory Evaluation and Current Debates in the Field. New Directions for Evaluation 1998(80) : 25‑41.

- Chanut, Véronique (2002) : L’évaluation: affaire d’État ou question d’organisation ? Politiques et Management public 20(4) : 1‑32.

- Clot, Hélène (2015) : La commande d’évaluation participative : une pratique hétérogène. In L’évaluation participative : de la prise en compte des publics au pouvoir d’agir citoyen, Les cahiers de la SFE.

- Cousins, J. Bradley (2003) : Utilization Effects of Participatory Evaluation. In International Handbook of Educational Evaluation, Dordrecht: Springer Netherlands, 245‑65.

- Cousins, J. Bradley/Whitmore, Elizabeth (1998) : Framing Participatory Evaluation. New Directions for Evaluation 1998(80) : 5‑23.

- Delahais, Thomas/Devaux-Spatarakis, Agathe (2018) : Évaluation des politiques publiques et sociologie : état des lieux d’une relation distanciée. Sociologies pratiques 36(1) : 47‑56.

- Dubois, Vincent (2012) : Le rôle des street-level bureaucrats dans la conduite de l’action publique en France. In La France et ses administrations. Un état des savoirs., éd. J M Eymeri-Douzans et G Bouckaert. Bruxelles, 1‑10.

- Euréval (2009) : Evaluation of plan D/Debate Europe citizen consultations projects. DG COMM European Commission.

- Houle, Sylvain (2018) : Introduction. In L’évaluation axée sur la rencontre des parties prenantes, une sagesse pratique. M. Hurteau, I. Bourgeois, S. Houlle (eds), Québec: Presses de l’Université de Québec, 131‑48.

- Hutchings, Claire (2016) : From Ferraris to Fiats. Allocution at the European Evaluation Society, Maastricht.

- Jacob, Steve/Ouvrard, Laurence (2009) : L’évaluation participative: avantages et difficultés d’une pratique innovante. Laval: Université Laval. Laboratoire de recherche Performance & Évaluation.

- Lascoumes, Pierre/Varone, Frédéric/Pons, Xavier (2006) : L’évaluation des politiques publiques entre enjeu politique et enjeu de méthode. Les cahiers du CEVIPOF, 44: 124.

- Lemire, Sebastian/Peck, Laura R./Porowski, Allan (2020) : The Growth of the Evaluation Tree in the Policy Analysis Forest: Recent Developments in Evaluation. Policy Studies Journal 48(S1).

- Lipsky, Michael (1981) : Street-Level Bureaucracy: Dilemmas of the Individual in Public Services. Michigan Law Review 79(4) : 811.

- Manin, Bernard (1985) : Volonté générale ou délibération ? : Esquisse d’une théorie de la délibération politique. Le Débat 33(1) : 72.

- Marchand, Marie-Pier (2018) : Où en sommes-nous avec l’implication des parties prenantes ? Canadian Journal of Program Evaluation 33(2).

- Michie, Susan/van Stralen, Maartje M./West, Robert (2011) : The behaviour change wheel: a new method for characterising and designing behaviour change interventions. Implementation Science 6(1) : 1.

- Monnier, Éric et al. (1992) : Évaluations de l’action des pouvoirs publics, Economica.

- Monnier, Éric/Duran, Patrice (1992) : Le développement de l’évaluation en France. Nécessités techniques et exigences politiques. Revue française de science politique 42(2) : 235‑62.

- Monnier, Éric/Varone, Frédéric/Sage, Karine (2008) : Évaluer une politique publique avec ses groupes cibles ou avec ses bénéficiaires finaux ? L’évaluation des politiques publiques en Europe. Cultures et futurs. L’ Harmattan/Société Française de l’Evaluation: 251.

- Mons, Nathalie (2018) : Interactions recherche-communauté éducative : les concepts de forum de politiques publiques, ideational broker et évaluation participative à l’épreuve des faits. Revue française de pédagogie (202) : 19‑28.

- Patton, Michael Quinn (2018) : 6. L’intervention auprès des parties prenantes. Le rôle et les responsabilités de l’évaluateur à titre d’animateur. In L’évaluation axée sur la rencontre des acteurs une sagesse pratique. M. Hurteau, I. Bourgeois, S. Houlle (eds), Québec: Presses de l’Université de Québec.

- Perret, Bernard (2008) : L’évaluation des politiques publiques. Paris: La Découverte.

- Picciotto, Robert (2018) : Is evaluation obsolete in a post-truth world? Evaluation and program planning 73: 88‑96.

- Plottu, Béatrice/Plottu, Éric (2009) : Approaches to Participation in Evaluation. Evaluation 15(3) : 343‑59.

- Quadrant Conseil (2020). Évaluation du programme VILCO. Innov’Iris.

- Ridde, Valéry (2006) : Suggestions d’amélioration d’un cadre conceptuel de l’évaluation participative. Canadian Journal of Program Evaluation 21(2) : 23.

- Robert, Émilie et al. (2018) : Rien ne doit se faire pour eux sans eux: renforcer la participation des demandeurs d’asile, réfugiés et migrants sans statut et des organismes communautaires dans la recherche en santé. Canadian Journal of Public Health.

- SFE. 2016. Observatoire de l’évaluation des politiques publiques. SFE.

- Tevini, Marc (2021) : Qu’est-ce que l’analyse militante apporte à l’évaluation des politiques publiques ? Revue française d’administration publique. nº 177.

- Venturini, Tommaso (2008) : La cartographie de controverses. Communication au colloque CARTO 2.0, Paris.

- 1 L’EP est par exemple présentée comme une innovation déjà présente en France en 1987 (Baron et Monnier 2003) ; une pratique innovante en 2009 (Jacob et Ouvrard 2009) ; et encore très récemment en 2020 comme une « tendance émergente » (Lemire, Peck, et Porowski 2020).

- 2 Pour la distinction entre « collaboratif » et « participatif » voir Marchand (2018).

- 3 Les critiques faites à l’EP, sur sa faible technicité ou son caractère subjectif portent souvent dans notre expérience sur des dispositifs de ce type. Pour une présentation de ces critiques, voir Jacob et Ouvrard 2009.

- 4 Pour un exemple européen, voir Euréval (2009).

- 5 Selon le cadre de William Ninacs, rapporté par Valéry Ridde (2006).

- 6 Ces actions, menées à l’échelle départementale, portaient par exemple sur la réduction de l’exposition à l’amiante sur les chantiers, sur le respect des temps de travail par les ambulanciers ou sur la garantie des règles d’hygiène et sécurité dans le commerce.

- 7 Ce chiffre ne représente pas forcément toute l’EP en France. En effet, le calcul porte sur un échantillon dans certains secteurs, et certains domaines, notamment l’action sociale, qui peuvent être plus porteurs que d’autres (SFE 2016).

- 8 Ce phénomène est bien connu dans le monde de la participation (Blondiaux et Sintomer 2002).

- 9 Voir l’exemple de ces parcs naturels régionaux ayant suivi les préconisations d’une EP ayant impliqué les habitants du Parc, mais devant rétropédaler sous la pression d’acteurs influents (Monnier, Varone et Sage 2008).

- 10 Jean-Claude Barbier rappelle ainsi que les EP mises en place en France par le Conseil scientifique de l’évaluation dans les années 1990 avaient une double légitimité, scientifique et politique (Barbier 2010).

- 11 Nous reprenons ici à des fins d’analyse le cadre COM-B proposé par Susan Michie, Maartje M. van Stralen et Robert West (2011). Il existe de nombreuses ressources précisant les conditions de succès des EP, voir notamment en français Isabelle Bourgeois et Marthe Hurteau (2018), ainsi que Steve Jacob et Laurence Ouvrard (2009).

- 12 Cet outil d’animation vise à faire apparaître les dissensus entre votants, de façon à concentrer les échanges sur les points de désaccord.

- 13 Pour un exemple, voir Bilodeau (2006).

- 14 Sur l’importance de ces aspects dans une démarche participative, voir Quadrant Conseil (2020).

- 15 Les théories du changement rassemblent l’ensemble des hypothèses relatives aux conséquences attendues d’une intervention évalue, dans quels cas, pourquoi et comment.

- 16 Pour une discussion des théories de Rawls et Habermas et les conséquences sur la délibération politique, voir Bernard Manin (1985, 19‑20). Sur les implications du modèle délibératif sur la vision des conflits dans la société, voir Loïc Blondiaux (2008).

- 17 Ce terme proposé par Bruno Latour décrit un exercice pédagogique visant à investiguer les débats sociotechniques contemporains. Il induit notamment une représentation cartographique desdites controverses (Venturini 2008). Nous l’utilisons ici dans le sens d’une enquête sur les acteurs des controverses visant à établir les différentes versions de ce qui se passe et ce qui est en jeu dans l’action publique.