Table des matières

Damit Evaluationen ihren Nutzen entfalten können, ist die Nutzung der Ergebnisse und Erkenntnisse essenziell. Dies umfasst unter anderem die Umsetzung der Evaluationsergebnisse von realen Personen in der realen Welt (Patton 2012, S. 4). In diesem Kontext sieht Patton (2012, S. 338) die Generierung von Empfehlungen als einen wesentlichen Evaluationsschritt. Sie bereiten die Nutzung von Evaluationsergebnissen vor. Empfehlungen in Evaluationsberichten sind auf Basis von Evaluationsergebnissen formulierte Handlungsimplikationen und beantworten die Frage nach dem «Was nun»? (Patton 2012, S. 337). Es kann unterschiedlich «angemessen» sein, Empfehlungen aus Evaluationen heraus zu entwickeln (Balzer/Beywl 2018, S. 132). Manche Autoren finden die Integration von Empfehlungen in Evaluationsberichte wenig sinnvoll: «An evaluation without recommendations (or explanations) is like a fish without a bicycle» (Scriven 2007, S. 16). Andere Autoren wiederum sehen Empfehlungen als integralen Bestandteil von Evaluationen: «In fact, we believe that evaluators should almost always offer recommendations» (Hendricks/Handley 1990, S. 110).

Patton (2012, S. 358) weist darauf hin, dass gut formulierte und sorgfältig entwickelte Empfehlungen das Element sein können, das die einzelnen Elemente der Evaluation zu einem sinnvollen Ganzen werden lassen. Gleichzeitig können schlecht gemachte Empfehlungen aber auch einen Angriffspunkt für Kritik darstellen.

Empfehlungen sind darauf ausgerichtet, Aspekte wie Effektivität, Effizienz, Impact, Relevanz oder Kohärenz des Evaluationsgegenstandes zu verbessern und als Grundlage für Entscheidungsfindungen, Programmgestaltung und für die Verteilung von Ressourcen zu dienen (UNEG SO2 Working Group 2018, S. 3). Damit sie diesen Nutzen entfalten können, müssen sie umgesetzt werden, wofür wiederum die Akzeptanz der Empfehlungen unerlässlich ist. Doch wie können Empfehlungen in Evaluationsberichten gestaltet werden, dass sie akzeptiert und umgesetzt werden?

Da Empfehlungen auf Basis von Evaluationsergebnissen formulierte Handlungsimplikationen sind, ist die Qualität des gesamten Evaluationsprozesses, der zur Generierung dieser Ergebnisse führt, ausschlaggebend für die Qualität von Empfehlungen. So beschreiben Oman und Chitwood (1984, S. 288) auch Faktoren der Planung und Durchführung von Evaluationen (bspw. die gewählte Methodik für die Erhebung und Analyse der Daten, der Evaluationszweck) als relevant für die Akzeptanz und Umsetzung von Empfehlungen. Die Qualität von Evaluationen entsteht durch das Zusammenwirken verschiedener, an einer Evaluation beteiligter Akteure (Schweizerische Evaluationsgesellschaft (SEVAL) 2016, S. 1). Somit haben indirekt nicht allein die Evaluierenden einen Einfluss auf die Qualität der Empfehlungen. Gleichzeitig beschreiben Oman und Chitwood (1984, S. 289) aber auch, dass spezifisch die Herleitung und Formulierung von Empfehlungen deren Akzeptanz und Umsetzung beeinflussen – ein Prozessschritt, der häufig primär in der Verantwortlichkeit von Evaluierenden liegt.

«Our readers devote only 5% of their attention to our findings and 95% of their attention to our recommendations. Yet I think we spend 95% of our time on study findings and only 5% of it on developing recommendations» (Hendricks/Handley 1990, S. 111). Dieses Zitat verdeutlicht die Wichtigkeit, der Herleitung und Formulierung von Empfehlungen einen ausreichenden Stellenwert beizumessen und dabei einige zentrale Dinge zu beachten. Dazu existieren bereits verschiedene Orientierungshilfen, die Evaluierende bei der Herleitung und Formulierung von Empfehlungen nutzen können (bspw. Bourgeois/Whynot 2018; Feinstein 2019; Hendricks/Handley 1990; Hendricks/Papagiannis 1990; Patton 2012, S. 358ff; Schweizerische Evaluationsgesellschaft (SEVAL) 2016, Standard C3; UNEG SO2 Working Group 2018; für einen Zusammenzug der in diesen Quellen gegebenen Hinweise siehe Tabelle 1).

Eine Gegenüberstellung der in den verschiedenen Orientierungshilfen zur Herleitung und Formulierung von Empfehlungen erwähnten Hinweise verdeutlicht sowohl Gemeinsamkeiten als auch Unterschiede. Alle der beispielhaft angegebenen Quellen weisen darauf hin, dass Empfehlungen aus den Evaluationsergebnissen abgeleitet werden und mit diesen kohärent sein sollen. Andere Aspekte werden in mehreren, aber nicht in allen Quellen erwähnt. So weisen zum Beispiel mehrere der Autoren darauf hin, dass potenzielle Nutzende der Empfehlungen in deren Entwicklung eingebunden werden sollten, dass die Empfehlungen sinnvoll strukturiert und klar formuliert und auch ohne spezifische Kenntnisse der Evaluation verständlich sein sollten und dass die Adressaten von Empfehlungen benannt werden sollten. Manche Aspekte werden hingegen nur in ein oder zwei der beschriebenen Orientierungshilfen erwähnt. Ein Beispiel ist der Hinweis aus der Checkliste der United Nations Evaluation Group (UNEG SO2 Working Group 2018, S. 5), dass zwischen den Empfehlungen eine interne Konsistenz hergestellt werden sollte. Andere Beispiele sind die Hinweise, dass im Evaluationsprozess genügend Zeit für die Entwicklung von Empfehlungen eingeplant werden sollte (Bourgeois/Whynot 2018, S. 14) oder dass Empfehlungen Indikatoren zum Monitoring ihrer Umsetzung enthalten sollten (Feinstein 2019, S. 3).

Die Tatsache, dass die verschiedenen Quellen verschiedene Hinweise beinhalten, lässt die Frage offen, welche der gegebenen Hilfestellungen für die Praxis von Evaluierenden tatsächlich relevant sind. Daraus ergibt sich die erste in diesem Artikel betrachtete, explorative Fragestellung:

Fragestellung 1: Welche der in der Literatur und in Checklisten gegebenen Hinweise zur Herleitung und Formulierung von Empfehlungen erachten Evaluierende als relevant für die eigene Arbeit?

In der oben dargestellten Literatur wird nicht genauer auf die Perspektive von Adressaten1 der Empfehlungen eingegangen. Es kann daraus nicht generell geschlossen werden, dass es zu dieser Perspektive keine Literatur gibt. Gleichzeitig ergibt sich aber ein erster Hinweis, dass sie bislang nicht in grosser Ausführlichkeit in der Literatur behandelt wurde. Die Identifikation von projektübergreifenden Merkmalen, welche die Perspektive von Adressaten beschreiben, kann jedoch helfen, Empfehlungen entsprechend herzuleiten und zu formulieren. Daraus ergibt sich die zweite in diesem Artikel betrachtete explorative Fragestellung:

Fragestellung 2: Welche Merkmale machen für Adressaten gute, akzeptierte und umsetzbare Empfehlungen aus?

Um zu ermitteln, welche in der Literatur gegebenen Hinweise zur Herleitung und Formulierung von Empfehlungen Evaluierende in ihrer Arbeit als relevant und wichtig erachten, erfolgte eine Befragung von Evaluierenden. Im Folgenden wird das methodische Vorgehen zusammengefasst, bevor die wichtigsten Ergebnisse dargestellt werden.

Zur Entwicklung des Fragebogens wurden die jeweiligen Hinweise zur Herleitung und Formulierung von Empfehlungen aus fünf verschiedenen Quellen (Bourgeois/Whynot 2018; Feinstein 2019; Hendricks/Papagiannis 1990; Schweizerische Evaluationsgesellschaft (SEVAL) 2017; UNEG SO2 Working Group 2018) extrahiert und einander gegenübergestellt.2 Die in mehreren Quellen enthaltenen Aspekte wurden so umformuliert, dass der verbindende Kern betont wurde. Nur einmal vorkommende Faktoren wurden durch Umformulierung auf das gleiche Abstraktionsniveau gebracht wie die mehrfach genannten Aspekte. Zum Teil wurden die Formulierungen auch gekürzt, um sie für einen Fragebogen nutzbar zu machen.

Orientiert an der Struktur der Checkliste der United Nations Evaluation Group (UNEG SO2 Working Group 2018), gliedert sich der Fragebogen in drei Teilbereiche:

- Prozess der Entwicklung von Empfehlungen (sieben Aspekte)

- Form und Struktur der Empfehlungen (zehn Aspekte)

- Inhalt von Empfehlungen (14 Aspekte)

Zu den insgesamt 31 Aspekten (s. Tabelle 1) wurde folgende Frage gestellt: «Wie relevant sind die folgenden Aspekte in Bezug auf [den Prozess der Entwicklung/Form und Struktur/den Inhalt] von Empfehlungen für Ihre Arbeit als Evaluierende?». Die Beurteilung erfolgte auf einer Likert-Skala (1 = nicht relevant; 2 = eher nicht relevant; 3 = eher relevant; 4 = relevant; 5 = weiss nicht) getrennt nach Evaluationen mit den Zwecken Rechenschaftslegung bzw. Lernen.

| Prozessbezogene Aspekte |

|

|

|

|

|

|

|

| Form- und strukturbezogene Aspekte |

|

|

|

|

|

|

|

|

|

|

| Inhaltsbezogene Aspekte |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Tabelle 1: Im Fragebogen für Evaluierende abgefragte Aspekte zur Herleitung und Formulierung von Empfehlungen

Die Rekrutierung der Teilnehmenden der Befragung erfolgte im beruflichen Umfeld der Autorin. Das Team Wirkungsmanagement von Gesundheitsförderung Schweiz führt eine Liste mit Evaluationsinstituten sowie Instituten von Fachhochschulen und Universitäten in der Schweiz, mit denen bereits im Rahmen von Evaluationen zusammengearbeitet wurde oder die Interesse an Evaluationsaufträgen von Gesundheitsförderung Schweiz signalisiert haben. Basierend auf dieser Liste wurden insgesamt 46 Anfragen zur Teilnahme an der Online-Befragung verschickt. Bei Hochschulinstituten wurde die Anfrage an spezifische Personen verschickt, bei Evaluationsinstituten dagegen zum Teil auch an allgemeine Kontakt-Adressen (im Sinne von info@institut-xy.ch). Wenn bereits Kontakt zu einzelnen Personen aus den Evaluationsinstituten bestand, wurden diese direkt angeschrieben. Das Anschreiben enthielt sowohl die Bitte, das Mail intern weiterzuleiten, als auch einen Hinweis, dass die Teilnahme vollständig anonym und freiwillig sei. Während einer Laufzeit von zwei Wochen (26.06.2020 bis 10.07.2020) beantworteten insgesamt 25 Personen mindestens eine der Fragen. Basierend auf dem Versand von 46 Anfragen entspricht dies einer Rücklaufquote von 54%. Die tatsächliche Rücklaufquote kann jedoch nicht bestimmt werden, da unbekannt ist, wie viele Personen die Anfrage durch Weiterleitung tatsächlich erhalten haben.

Bei den 19 Personen, die die Frage nach der Dauer ihrer Berufserfahrung als Evaluierende beantwortet haben, lag diese zwischen Min = 3 Jahren und Max = 30 Jahren (M = 15.58 Jahre, SD = 8.28 Jahre). Nur fünf Personen gaben an, weniger als zehn Jahre Erfahrung als Evaluierende zu haben. Insgesamt handelt es sich also um eine Stichprobe von erfahrenen Evaluierenden.

Für jeden der 31 Aspekte wurden mithilfe des Statistikprogramms R (R Core Team, 2020) pro Person über die beiden Dimensionen «Rechenschaftslegung» und «Lernen» Median (Mdn) resp. Mittelwert (M), Standardabweichung (SD), Minimum (Min) und Maximum (Max) berechnet. Die Histogramme der Variablen weisen auf eine linksschiefe Verteilung hin. Daher kann anhand der Standardabweichung keine Annahme darüber getroffen werden, wie viele Werte sich in einem bestimmten Bereich um den Mittelwert befinden.

Zum Einstieg in die Befragung wurde die Frage gestellt, in wie viel Prozent der Evaluationsprojekte Empfehlungen abgeleitet werden. Es zeigt sich, dass die Befragten häufig Empfehlungen ableiten: Der Median liegt bei Mdn = 95%. Eine Person gab an, in nur 5% der Projekte Empfehlungen abzuleiten, alle anderen gaben Werte von 65% und grösser an. Von den 25 Personen gaben 19 an, in 90% oder mehr der Fälle Empfehlungen zu formulieren. Es werden also in den meisten Evaluationsprojekten Empfehlungen abgeleitet.

Die Einschätzung der Relevanz der verschiedenen Hinweise wurde differenziert für die beiden Evaluationszwecke «Rechenschaftslegung» und «Lernen» erfasst. Insgesamt zeigten sich zwischen den beiden Evaluationszwecken in den Ergebnissen jedoch kaum Unterschiede. Daher werden die Ergebnisse summarisch für beide Evaluationszwecke dargestellt.

Die Fragestellung 1 bezieht sich auf die Frage, welche Hinweise von den Evaluierenden zur Herleitung und Formulierung von Empfehlungen als relevant für die eigene Arbeit erachtet werden. Insgesamt lässt sich bei dieser Einschätzung ein Deckeneffekt erkennen: Fast alle Aspekte (81%) werden im Mittel als «(eher) relevant» (2.5 ≤ M ≤ 43) betrachtet. Ein solcher Deckeneffekt ist nicht überraschend, da es sich bei den abgefragten Aspekten um vorselektierte Hinweise handelt. Trotz des Deckeneffekts ist eine gewisse Varianz und Abstufung zwischen den einzelnen Aspekten zu erkennen: Für die meisten Items nimmt die Einschätzung Werte zwischen 1 und 4 an. Die Teilnehmenden schätzen die Relevanz der verschiedenen Aspekte für die eigene Praxis demnach unterschiedlich ein.

In Tabelle 2 sind die zehn über alle Bereiche hinweg als am relevantesten eingestuften Aspekte aufgeführt, gruppiert nach drei inhaltlichen Kategorien (s. Spalte «Kategorisierung»).

Tabelle 2: Die zehn als am relevantesten eingestuften Aspekte

Das Gesamtbild zeigt, dass es für die Arbeit von Evaluierenden relevant zu sein scheint, die Empfehlungen auf einer breiten und nachvollziehbaren Informationsbasis abzustützen. Bei den prozessbezogenen Aspekten sind Hinweise besonders relevant, die sich auf das Einbeziehen verschiedener Informationsquellen für das Herleiten von Empfehlungen beziehen. Dazu passend wird aus dem Teilbereich «Inhalt» der Hinweis als relevant eingeschätzt, dass die Empfehlungen einen klaren und kohärenten Bezug zu den Schlussfolgerungen der Evaluation haben sollten und die Ergebnisse und Schlussfolgerungen der Evaluation somit als Basis für die Empfehlungen dienen.

Ein zweiter relevanter Bereich von Hinweisen für die Arbeit der Evaluierenden scheint die klare, strukturierte und kohärente Darstellung der Empfehlungen in den Evaluationsberichten zu sein. Diese Kategorie bezieht sich auf Aspekte der Form und Struktur und beschreibt die klare Kennzeichnung und Kategorisierung von Empfehlungen sowie das Herstellen einer internen Konsistenz zwischen den Empfehlungen.

Ein dritter relevanter Bereich ist die verständliche und adressatengerechte Formulierung der Empfehlungen: Zum einen ist zu beachten, die Empfehlungen so zu formulieren, dass sie auch ohne spezifische Kenntnisse der Evaluation verständlich sind. Zum anderen sollten sie adressatengerecht formuliert sein und dabei auch benennen, wer für die Umsetzung der Empfehlungen verantwortlich ist.

Insgesamt ergibt sich das Bild, dass die Hinweise in Bezug auf den Prozess zur Herleitung sowie bezüglich Form und Struktur etwas relevanter sind als die Hinweise in Bezug auf den Inhalt der Empfehlungen. Dies könnte darauf zurückzuführen sein, dass die inhaltlichen Aspekte zum Teil sehr ins Detail und je nach Auslegung der Rolle auch über die Aufgabe von Evaluierenden hinaus gehen (z.B. Integration einer Implementationsstrategie in die Empfehlungen). Die Aspekte, die sich auf den Prozess und die Form und Struktur beziehen, sind dagegen grösstenteils etwas allgemeiner formuliert, sodass sie eventuell aus diesem Grund für die tägliche Arbeit relevanter sind. Eine andere Erklärung könnte sein, dass die Hinweise bezüglich Prozess sowie Form und Struktur etwas einfacher umzusetzen sind als diejenigen bezüglich Inhalt und deshalb als relevanter eingeschätzt werden. Bei der Interpretation ist jedoch zu beachten, dass es sich bei den drei Teilbereichen nicht um vollständig trennscharfe Kategorien handelt. Beispielsweise beziehen sich sowohl einzelne Aspekte des Prozesses als auch Aspekte des Inhalts auf die Frage, auf Basis welcher Informationen Empfehlungen entstehen sollen. Vergleichende Interpretationen sollten somit mit Vorsicht angestellt werden.

Um die zweite Fragestellung zu beantworten, durch welche Merkmale sich gute, akzeptierte und umsetzbare Empfehlungen aus der Sicht von Adressaten von Empfehlungen auszeichnen, erfolgte eine Befragung von Entscheidungsträgern und Projektverantwortlichen bei Gesundheitsförderung Schweiz. Im Folgenden wird das methodische Vorgehen zusammengefasst, bevor auch für diese Befragung die wichtigsten Ergebnisse dargestellt werden.

Der Fragebogen für Adressaten von Empfehlungen bestand aus vier kurzen, aufgrund des explorativen Charakters der Fragestellung offenen Fragen. Für offene Fragen sprach auch die Tatsache, dass Adressaten von Empfehlungen nicht zwangsläufig mit der Evaluationsterminologie vertraut sind, sodass eine geschlossene Befragung bei dieser Gruppe womöglich zu ungültigen Ergebnissen hätte führen können. Zwei Fragen waren im weitesten Sinne an der Methode kritischer Ereignisse (critical incident technique (CIT)) orientiert (Flanagan 1954): «Bitte denke an Empfehlungen (oder stelle Dir solche vor), die Du besonders [gut (Frage 1)/schlecht (Frage 2)] gelungen fandest: Welche Merkmale haben sie zu besonders [gut/schlecht] gelungenen Empfehlungen gemacht?». Zusätzlich wurden zwei Fragen dazu ergänzt, welche Merkmale Empfehlungen zu «akzeptierten» und «umsetzbaren» Empfehlungen machen.

Die Rekrutierung der Teilnehmenden an der Befragung erfolgte bei Gesundheitsförderung Schweiz. Es wurden alle Einheits- und fast alle Teamleitenden sowie eine Auswahl von Projektleitenden, die bereits mit Evaluationsberichten gearbeitet hatten, angeschrieben. Während einer Laufzeit von zweieinhalb Wochen (22.07.2020 bis 07.08.2020) haben 15 von 20 angeschriebenen Personen den Fragebogen ausgefüllt (Rücklaufquote 75%). Dabei handelt es sich um drei Einheitsleitende (20%), fünf Teamleitende (33.33%) und sieben Projektleitende (46.67%).

Um ein Gesamtbild über die Perspektive der Adressaten von Empfehlungen zu gewinnen, wurden pro Person die Antworten auf alle vier Fragen nicht getrennt voneinander, sondern gesamthaft ausgewertet. Über alle Personen und alle Fragen hinweg wurden insgesamt 225 Antworten gegeben. Da die gestellten Fragen jedoch nicht trennscharf sind, wurden pro Person doppelt genannte Aspekte gestrichen. Dieser Schritt führte zu einer Reduktion auf verbleibende 168 Antworten. Neunzehn Antworten waren bezogen auf die Fragen nicht auswertbar (beispielsweise Merkmale, die sich auf den Inhalt von in Projekten ausgesprochenen Empfehlungen, auf Charakteristika der Evaluation oder den Valorisierungsprozess bezogen; Merkmale, die so knapp formuliert waren, dass eine Interpretation nicht möglich war).

Die verbliebenden 149 Antworten wurden mit einer Kombination aus deduktiver und induktiver Kategorisierung (Mayring/Fenzl 2014, S. 546) in Kategorien zusammengefasst. Zunächst wurden die Merkmale deduktiv den 31 Aspekten aus der Befragung für Evaluierende zugeordnet. Für manche Antworten ergab sich jedoch keine trennscharfe Zuordnung zu nur einem der 31 Aspekte. In der Konsequenz wurden induktiv verschiedene der 31 Aspekte zu übergeordneten Kategorien zusammengefasst und einzelne ergänzende Kategorien erstellt. Mit diesem Vorgehen konnte eine maximale Anzahl von Antworten der Adressaten von Empfehlungen zusammengefasst werden, wobei gleichzeitig ein Bezug zu den Aspekten aus der Befragung von Evaluierenden möglich wurde.

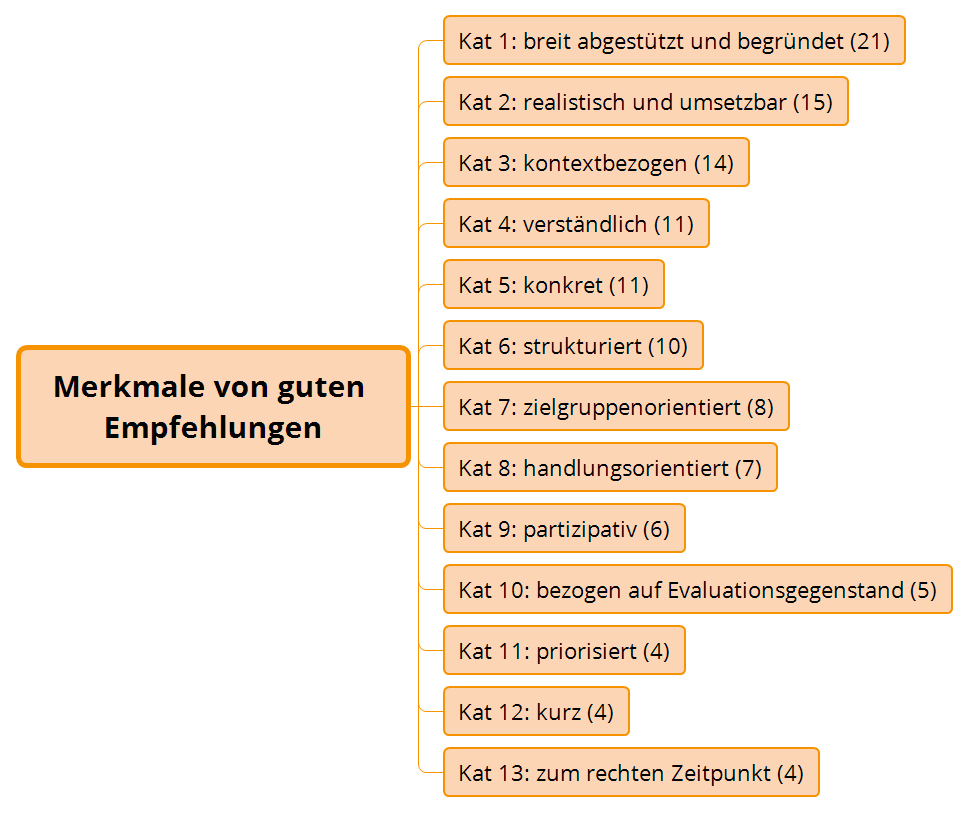

Die Fragestellung 2 untersuchte, mit welchen Merkmalen Adressaten von Empfehlungen bei Gesundheitsförderung Schweiz Empfehlungen als gut, schlecht, akzeptiert und umsetzbar charakterisieren. Aus der Vielzahl von genannten Aspekten haben sich 13 Kategorien ergeben (s. Abbildung 1). Die drei Kategorien «breit abgestützt und begründet», «realistisch und umsetzbar» und «kontextbezogen» beinhalteten dabei besonders viele Nennungen und scheinen den Projektverantwortlichen und Entscheidungsträgern besonders wichtig zu sein.

Abbildung 1: Aus den Antworten der Projektverantwortlichen und Entscheidungsträger abgeleitete Kategorien zu guten Empfehlungen; in Klammern angegeben sind die Anzahl der Nennungen pro Kategorie

In der Kategorie «breit abgestützt und begründet» wird in manchen Nennungen ein direkter Bezug der Empfehlungen zu den Evaluationsergebnissen als wichtig erachtet («Enge Verbindung mit den Ergebnissen der Evaluation»). Andere Nennungen gehen explizit auf den Einbezug anderer Quellen für die Herleitung und Begründung von Empfehlungen ein («Einbezug von wissenschaftlichen Experten»). Die meisten Nennungen sind recht allgemein gehalten («fundiert», «gut hergeleitet», «begründet»).

Bei dem zweiten für Adressaten von Empfehlungen wichtigen Merkmal «realistisch und umsetzbar» verwenden die meisten Nennungen explizit und ganz allgemein eines der beiden Wörter «realistisch» oder «umsetzbar». Einzelne Nennungen werden dagegen etwas spezifischer, z.B. «realistisch (berücksichtigt den Auftrag und die Ressourcen des Empfängers)» oder «Realisierbar aufgrund des Kontextes (bspw. finanzielle und personelle Ressourcen, fachliche Kompetenzen, politischer Kontext)».

Die dritte Kategorie «kontextbezogen» zeigt in einzelnen Nennungen eine gewisse Überschneidung mit der Kategorie «realistisch und umsetzbar», bezieht sich aber stärker darauf, dass die Realität und der Kontext des Evaluationsgegenstandes bei den Empfehlungen berücksichtigt werden sollte (z.B. «Die Empfehler kennen den Kontext derjenigen, denen sie Empfehlungen geben»).

Der Vergleich der Perspektiven von Evaluierenden und Adressaten von Empfehlungen zeigt sowohl Überschneidungen als auch Unterschiede. Der Fokus wurde bei dem Abgleich auf die Kategorien gelegt, die von den Adressaten von Empfehlungen acht Mal oder öfter genannt wurden. In Abbildung 2 sind dabei die Aspekte, die gleichzeitig unter den zehn von den Evaluierenden als am relevantesten eingeschätzten Aspekten zu finden waren, grün hinterlegt. Rot hinterlegt sind die Aspekte, bei denen es keine Überschneidung mit den zehn von den Evaluierenden als am relevantesten eingeschätzten Aspekten gab.

Abbildung 2: Abgleich der Perspektiven von Evaluierenden und Adressaten von Empfehlungen

Die Erwartung, dass Empfehlungen auf einer breiten Informationsbasis entstehen, gut begründet und in Zusammenhang mit den Evaluationsergebnissen stehen sollen, wird von den Adressaten von Empfehlungen sowie Evaluierenden geteilt (Kat. 1): Für die Adressaten von Empfehlungen ist dies eines der wichtigsten Merkmale von guten Empfehlungen, während die Evaluierenden in diesem Bereich vier Hinweise als relevant für die eigene Praxis erachten. Übereinstimmung besteht auch in Bezug auf die Ansicht, dass Empfehlungen verständlich formuliert (Kat. 4) und strukturiert präsentiert (Kat. 6) werden sollen. Auch hinsichtlich der Tatsache, dass Empfehlungen zielgruppenorientiert formuliert sein sollen, sind sich Adressaten von Empfehlungen und Evaluierende einig (Kat. 7).

Mindestens so aufschlussreich wie die Aspekte, bei denen Übereinstimmung besteht, sind die Aspekte, bei denen die Einschätzungen von Adressaten von Empfehlungen von denen der Evaluierenden abweichen. Einer dieser Aspekte ist die Frage, wie realistisch und umsetzbar Empfehlungen sein sollten. Für Adressaten von Empfehlungen ist dies ein zentrales Merkmal von Empfehlungen, während es von Evaluierenden als «eher nicht relevant» für die eigene Arbeit eingeschätzt wird. Für diese Differenz kann es unterschiedliche Erklärungen geben. Das Item im Fragebogen für Evaluierende lautete «Sicherstellen, dass die Empfehlungen umsetzbar und realistisch sind (im Sinne von «best result possible» statt «best possible result»)». Der Zusatz in der Klammer geht über den reinen Aspekt von realistischen und umsetzbaren Empfehlungen hinaus. Es ist möglich, dass der Unterschied in der Einschätzung durch diesen Zusatz entstanden ist. Gleichzeitig kann der Unterschied aber auch inhaltlich begründet sein. Für Adressaten von Empfehlungen könnte es praktisch sein, wenn die Empfehlungen so formuliert sind, dass sie 1:1 umgesetzt werden können. Aus Sicht der Evaluierenden könnte es dagegen auch ein Ansatz sein, Empfehlungen auszusprechen, die auf einen (idealen) Zielzustand hinarbeiten und es in der Verantwortung der Projektverantwortlichen zu belassen, zu entscheiden, welcher Schritt dazu in welchem Masse umgesetzt werden kann. Beide Perspektiven haben ihre Berechtigung und es ist wichtig, gemeinsam zu besprechen, was erwartet und was möglich ist.

Ein zweiter Aspekt, bei dem die Einschätzungen auseinander gehen, ist die Frage, wie stark die Empfehlungen den Kontext des jeweiligen Projekts berücksichtigen sollten. Für Adressaten von Empfehlungen ist dieser Aspekt sehr wichtig. In der Einschätzung der Evaluierenden ist dieser Aspekt nicht unter den zehn relevantesten Aspekten, wird im Mittel aber immer noch als «relevant» eingestuft. Hinsichtlich dieses Aspektes sollte mit den Adressaten der Empfehlungen kritisch reflektiert werden, inwieweit ihre Erwartung für Evaluierende erfüllbar ist. Es stellt sich die Frage, ob die Evaluierenden den Projektkontext gut genug kennen, um Empfehlungen auf den Kontext zuzuschneiden, oder ob es in der Verantwortung der Projektverantwortlichen liegt, diese Übertragung selbst zu machen. Gegebenenfalls könnte es interessant sein, die Vermittlung von Kontextwissen, z.B. im Rahmen eines Interviews, explizit als Evaluationsschritt einzuplanen.

Ein dritter Aspekt, bei dem die Einschätzungen der befragten Akteure auseinander gehen, ist die Frage, wie konkret Empfehlungen formuliert sein sollten. Die Evaluierenden schätzen die explizite Entscheidung, wie konkret Empfehlungen formuliert sein sollten, nur als «eher relevant» für ihre Arbeit ein. Die Nennungen der Adressaten zeigen, dass sie unterschiedliche Meinungen zur Konkretheit von Empfehlungen haben. Einerseits wird explizit gewünscht, dass Empfehlungen konkret formuliert sein sollen. Andererseits gab es auch Nennungen, dass zu konkrete Empfehlungen als Einmischung in interne Prozesse verstanden werden. Vor diesem Hintergrund ist es gegebenenfalls entgegen der Einschätzung der Evaluierenden sehr relevant, diese Frage explizit gemeinsam zu diskutieren.

Basierend auf den oben dargestellten Ergebnissen hat das Team Wirkungsmanagement von Gesundheitsförderung Schweiz gemeinsam diskutiert, welche Schlussfolgerungen es für das Evaluationsmanagement ziehen kann. Der Fokus lag bei der Diskussion auf den Aspekten «realistisch und umsetzbar», «kontextbezogen» und «zielgruppenorientiert».

Orientiert am Evaluationsprozess wurden folgende Massnahmen abgeleitet:

- Vor Projektbeginn wird mit den internen Auftraggebenden besprochen, welche Vorstellungen sie bezüglich Empfehlungen haben sowie wer die Adressaten von Empfehlungen sind.

- Sind die Adressaten der Empfehlungen nicht direkt an der Evaluation beteiligt, sollten sie in einer Begleitgruppe mit einbezogen werden.

- Im Pflichtenheft werden die Adressaten potenzieller Empfehlungen beschrieben. Es wird zudem darauf eingegangen, wer die Evaluationserkenntnisse sowie die Empfehlungen in welcher Form nutzen sollte.

- In der Kick-off Sitzung zur Evaluation diskutieren Auftraggebende und Evaluierende gemeinsam, welche Vorstellungen zu Empfehlungen bestehen (z.B. anhand der Fragen: Wie konkret können und sollen Empfehlungen formuliert sein? Zu welchem Gegenstand soll es Empfehlungen geben?)

- Bei komplexen Evaluationen könnte im Evaluationsprozess ein Interview mit den Projektverantwortlichen vorgesehen werden, in dem die Vermittlung von Kenntnissen des Projektkontextes im Vordergrund steht.

- In der Checkliste für Evaluierende zur Gestaltung von Schlussberichten werden zwei Hinweise in Bezug auf Empfehlungen gegeben:

- Die Empfehlungen beruhen auf Schlussfolgerungen aus der Interpretation der Ergebnisse. Sie sind nachvollziehbar, realistisch und handlungsrelevant. Sie richten sich an eindeutige Adressaten und sind so strukturiert und formuliert, dass sich daraus Handlungen ableiten lassen.

- Der Bericht ist so strukturiert, dass […] Empfehlungen und Schlussfolgerungen leicht zu finden sind und dass Redundanzen vermieden werden.

- Evaluierende und Adressaten können die Empfehlungen vor der Finalisierung des Berichts gemeinsam diskutieren, um sie realistischer und umsetzbarer, kontextbezogener und zielgruppenorientierter zu gestalten. Bei einer solchen gemeinsamen Diskussion kann es zu einer Beeinflussung durch die Adressaten der Empfehlungen führen. Beeinflussungen sind allerdings nicht zwangsläufig negativ im Sinne von Verzerrung oder Zügelung, sondern können im Rahmen von Verbesserungen und Unterstützung auch einer konstruktiven Intention folgen (Pleger/Sager 2016, S. 39). Dem Evaluationsmanagement kommt deshalb die Rolle zu, destruktive von konstruktiver Beeinflussung zu unterscheiden sowie destruktive Beeinflussung zu verhindern. Dies gilt insbesondere bei Evaluationen, bei denen eine unabhängige Bewertung im Vordergrund steht.

Wird eine Evaluation nicht durch eine/n Evaluationsmanager/in begleitet, können Evaluierende darauf achten, die verschiedenen Aspekte in Abstimmung mit dem Auftraggebenden aufzugreifen.

Im Folgenden wird auf die wichtigsten Limitationen des Vorgehens eingegangen. Erstens hätten Interviews mit Adressaten der Empfehlungen eventuell tiefere Einblicke ergeben. Zweitens wäre eine umgekehrte Reihenfolge der beiden Befragungen gegebenenfalls sinnvoller gewesen: Aus den Antworten der Adressaten von Empfehlungen hätte ein zielgerichteterer Fragebogen für die Evaluierenden entwickelt werden können. Dies hätte vermutlich einen klareren Bezug zwischen den beiden Perspektiven sowie eventuell einen kürzeren Fragebogen für die Evaluierenden zur Konsequenz gehabt. Drittens weist der Fragebogen für Evaluierende gewisse Schwächen auf. Ein Reihenfolge-Effekt kann ein Grund für die tiefere Bewertung der Relevanz der inhaltsbezogenen Aspekte sein. Es wäre sinnvoll gewesen, die Reihenfolge der drei Blöcke sowie der Items innerhalb der Blöcke zu randomisieren. Zusätzlich gibt es sicher Quellen mit Hinweisen, die bei der Erstellung des Fragebogens nicht berücksichtigt wurden. Einschränkend ist bei dieser Limitation jedoch anzumerken, dass eine später gefundene Quelle (Patton 2012) keine Aspekte enthalten hat, die nicht im Fragebogen abgedeckt waren. Die Berücksichtigung zusätzlicher Quellen hätte somit vermutlich nicht zu einer Vielzahl zusätzlicher Hinweise geführt. Viertens erfolgte die Auswertung der zweiten Befragung fragen- und funktionsübergreifend. So ergibt sich zwar ein erstes «Big Picture», es wäre aber spannend, bei einer grösseren Stichprobe die genannten Aspekte differenziert nach Funktionen (Projektverantwortliche vs. Entscheidungsträger) und nach Fragen (Qualität von Empfehlungen, Akzeptanz, Umsetzbarkeit) auszuwerten, um ein detaillierteres Bild zu erhalten.

Fünftens ist die Stichprobe in mindestens zweifacher Hinsicht verzerrt. Zum einen handelt es sich um eine Auswahl von Personen, die einen direkten Bezug zur Arbeitswelt der Autorin haben. Die Perspektive der Adressaten von Empfehlungen kommt ausschliesslich von Mitarbeitenden von Gesundheitsförderung Schweiz. Auch wenn die Stichprobe der Evaluierenden als diverser betrachtet werden kann, ist auch diese durch die enge Rekrutierung eingeschränkt. Die Ergebnisse sind somit nur begrenzt generalisierbar. Zum anderen stand die Befragung der Evaluierenden aus praktischen Gründen ausschliesslich auf Deutsch zur Verfügung. Ein Abgleich mit der Perspektive von Evaluierenden aus anderen Sprachregionen wäre eine spannende und wichtige Ergänzung.

Wie können Empfehlungen in Evaluationsberichten gestaltet werden, dass sie akzeptiert und umgesetzt werden und so ihren Nutzen entfalten? Evaluierende und Adressaten von Empfehlungen sind sich darüber einig, dass sich Empfehlungen aus den Evaluationsergebnissen ableiten und kohärent zu diesen sein sollen. Daher ist die Qualität des gesamten Evaluationsprozesses für die Qualität der Empfehlungen relevant und alle daran beteiligten Akteure dafür verantwortlich. Spezifisch auf die Herleitung und Formulierung von Empfehlungen können Evaluierende dieser Erwartung gerecht werden, in dem sie in den Evaluationsberichten explizit und deutlich den Zusammenhang zwischen den Evaluationsergebnissen und den daraus abgeleiteten Empfehlungen darstellen (Feinstein 2019, S. 3).

Einigkeit besteht auch dazu, dass Empfehlungen verständlich formuliert werden sollten. Die einfache Verständlichkeit gilt dabei nicht nur spezifisch für die Empfehlungen, sondern für den Bericht allgemein (Schweizerische Evaluationsgesellschaft (SEVAL) 2016, Standard C4). Hendricks und Papagiannis (1990, S. 124) empfehlen, die Empfehlungen an der Evaluation nicht beteiligten Personen zum Gegenlesen zu geben und beurteilen zu lassen, ob diese ohne das entsprechende spezifische Wissen ausreichend verständlich sind.

Auch der Hinweis bezüglich einer nachvollziehbaren Struktur, den sowohl Evaluierende als auch Adressaten als wichtig erachten, gilt sowohl für die Berichterstattung allgemein (Schweizerische Evaluationsgesellschaft (SEVAL) 2016, Standard C4) als auch spezifisch für Empfehlungen. Adressaten von Empfehlungen wünschen sich hier eine Bündelung und eine Nummerierung der Empfehlungen sowie eine logische Reihenfolge, beispielsweise anhand von Evaluationsgegenstand, Themenschwerpunkten, Zeitfolge, Priorisierung, Adressat oder Abstraktionsniveau (strategisch vs. operativ). Patton (2012, S. 359) nennt ergänzend, dass Empfehlungen danach sortiert werden könnten, wie stark die Unterstützung (empirisch oder innerhalb des Evaluationsteams) ist, oder danach, als wie dringlich die Umsetzung der Empfehlung angesehen wird.

Des Weiteren sind sich Evaluierende und Adressaten von Empfehlungen darüber einig, dass die Zielgruppenorientierung wichtig für die Qualität von Empfehlungen ist. So ist auch in den Erläuterungen zu den SEVAL-Standards (Schweizerische Evaluationsgesellschaft (SEVAL) 2017, S. 16) festgehalten: «Empfehlungen sollen klar formuliert sein und konkret aufzeigen, wer was tun soll bzw. kann, um die Ergebnisse der Evaluation umzusetzen. Die zuständigen Adressatinnen und Adressaten sind zu benennen».

Für die Adressaten von Empfehlungen ist darüber hinaus zentral, dass Empfehlungen realistisch und umsetzbar, kontextbezogen und konkret sind. Spezifisch sollten Evaluierende darauf achten, dass, wie auch von Feinstein (2019, S. 3) und in den SEVAL-Standards (Schweizerische Evaluationsgesellschaft (SEVAL) 2017, S. 16) beschrieben, nur Empfehlungen ausgesprochen werden, die im Handlungsbereich der Adressaten liegen, dass personelle und finanzielle Ressourcen berücksichtigt werden sowie dass der Aufwand der Umsetzung in einem vernünftigen Verhältnis zu deren Umsetzung stehen.

Um die Empfehlungen kontextbezogen zu formulieren, wird von den Adressaten als zentral erachtet, dass die Evaluierenden den Kontext ausreichend kennen. Hier könnten Evaluierende ein Interview in den Evaluationsprozess integrieren, der das bessere Verständnis des Kontextes des Evaluationsgegenstands zum Ziel hat. Aus Sicht des Wirkungsmanagements von Gesundheitsförderung Schweiz könnte dies nicht nur den Empfehlungen, sondern der gesamten Evaluation zugutekommen.

Wie konkret Empfehlungen formuliert werden sollen, sollte zwischen Evaluierenden und Adressaten besprochen werden. Auch wenn die Adressaten von Empfehlungen überwiegend äusserten, dass die Empfehlungen konkret genug sein sollten, gab es auch Nennungen, dass die Empfehlungen den Umsetzenden noch genügend Handlungsspielraum lassen sollten. Auch wurden Empfehlungen dann als weniger gut empfunden, wenn durch sie eine zu starke Einmischung in interne Prozesse wahrgenommen wurde. Das passende Niveau an Konkretheit kann demnach stark abhängig von den Adressaten der Empfehlungen sein.

Auch wenn viele der genannten Aspekte in der Verantwortung der Evaluierenden liegt, sollte deren Umsetzung als kollaborativer Prozess betrachtet werden, um deren Umsetzung zu fördern und den Nutzen von Evaluationen zu erhöhen (Patton 2012, S. 361).

Dr. Regina Jensen, Projektleiterin Wirkungsmanagement (Schwerpunkt Betriebliches Gesundheitsmanagement) bei der Stiftung Gesundheitsförderung Schweiz.

Dieser Beitrag basiert auf der Abschlussarbeit des CAS Evaluation an der Universität Bern; Die Umsetzung (Kap. 5) wurde nach Abschluss der Arbeit gemeinsam mit dem Team Wirkungsmanagement erarbeitet. Vielen Dank für die gemeinsame Reflexion sowie die Unterstützung der CAS-Arbeit.

Herzlichen Dank ebenfalls an Prof. Dr. Wolfgang Beywl sowie Herrn Christian Rüefli, die im Rahmen der Betreuung und Begutachtung der CAS-Arbeit respektive im Rahmen des Lektorats dieses Artikels sehr wertvolle Hinweise gegeben haben.

Vielen Dank auch an alle Teilnehmende der Befragung für die wichtigen Einschätzungen.

- Balzer, Lars / Beywl, Wolfgang (2018): Evaluiert, 2., überarbeitete Auflage, Bern: hep verlag ag.

- Bourgeois, Isabelle / Whynot, Jane (2018): The influence of evaluation recommendations on instrumental and conceptual uses: A preliminary analysis, Evaluation and Program Planning, 68, S. 13–18. https://doi.org/10.1016/j.evalprogplan.2018.02.008

- Feinstein, Osvaldo (2019): Checklist for Evaluation Recommendations, https://wmich.edu/sites/default/files/attachments/u3036/2019/eval-rec-feinstein.pdf

- Flanagan, John C. (1954): The critical incident technique, Psychological Bulletin, 51(4), S. 327–358. https://doi.org/10.1037/h0061470

- Hendricks, Michael / Handley, Elisabeth A. (1990): Improving the recommendations from evaluation studies. Evaluation and Program Planning, 13(2), S. 109–117. https://doi.org/10.1016/0149-7189(90)90038-X

- Hendricks, Michael / Papagiannis, Meredith (1990): Do’s and Dont’s for Offering Effective Recommendations, Evaluation Practice, 11(2), S. 121–125. https://doi.org/10.1177/109821409001100205

- Mayring, Philipp / Fenzl, Thomas (2014): Qualitative Inhaltsanalyse, in: Baur, Nina / Blasius, Jörg (Hrsg.), Handbuch Methoden der empirischen Sozialforschung, Wiesbaden: Springer Fachmedien, S. 543–556, https://doi.org/10.1007/978-3-531-18939-0_38

- Oman, Ray C. / Chitwood, Stephen R. (1984): Management Evaluation Studies: Factors Affecting the Acceptance of Recommendations, Evaluation Review, 8(3), S. 283–305. https://doi.org/10.1177/0193841X8400800301

- Patton, Michael Quinn (2012): Essentials of Utilization-Focused Evaluation, Thousand Oaks (California): SAGE Publications.

- Pleger, Lyn / Sager, Fritz (2016): Die Beeinflussung in der Evaluationstätigkeit in der Schweiz und was die SEVAL dagegen tun kann, in: LeGes 27 (2016) 1, S. 33–49. https://leges.weblaw.ch/dam/publicationsystem_leges/2016/1/LeGes_2016_1_33-49.pdf

- R Core Team (2020): R: A language and environment for statistical computing (4.0.2) [Computer software], R Foundation for Statistical Computing. https://www.R-project.org/

- Schweizerische Evaluationsgesellschaft (SEVAL) (2016): Evaluationsstandards der Schweizerischen Evaluationsgesellschaft. https://www.seval.ch/app/uploads/2018/01/SEVAL-Standards-2016_d.pdf

- Schweizerische Evaluationsgesellschaft (SEVAL) (2017): Erläuterungen zu den Evaluationsstandards der Schweizerischen Evaluationsgesellschaft (SEVAL-Standards). https://www.seval.ch/app/uploads/2018/01/SEVAL-Standards_2016-Erläuterungen.pdf

- Scriven, Michael (2007): Key Evaluation Checklist. https://wmich.edu/sites/default/files/attachments/u350/2014/key evaluation checklist.pdf

- UNEG SO2 Working Group (2018): Improved Quality of Evaluation Recommendations Checklist. http://www.uneval.org/document/detail/2124

- 1 Verschiedene, an der Evaluation beteiligte Akteure können die Adressaten von Empfehlungen sein, z.B. Auftraggebende, Entscheidungsträger/innen oder auch Programmverantwortliche. Im Folgenden wird daher generisch der Begriff «Adressaten von Empfehlungen» verwendet.

- 2 Jegliche Materialien des Projekts sind auf Anfrage bei der Autorin erhältlich.

- 3 Der berechnete Mittelwert kann als stetige Variable jeden beliebigen Wert im Wertebereich 1 und 4 annehmen. Teilt man den Bereich in vier gleich grosse Abschnitte, ergeben sich für den Mittelwert folgende Abstufungen: 1 ≤ M ≤ 1.749 ≙ «nicht relevant»; 1.75 ≤ M ≤ 2.49 ≙ «eher nicht relevant»; 2.5 ≤ M ≤ 3.249 ≙ «eher relevant»; 3.25 ≤ M ≤ 4 ≙ «relevant».